摘要:学生评教留言经过逐年累积,已经形成一个巨量的信息资源,如何进行挖掘和分析这些资源已经成为一项紧迫的任务。本文采用频率、信息增益、条件概率比、期望值差异等四种特征选取方法对留言进行分析,采用ICTCLAS分词软件进行分词,利用MATLAB软件进行矩阵奇异值分解和降维,使用支持向量机进行训练和预测数据,从而能够对学生留言的情感倾向性给出很好的预测结果。最后通过实例说明了文中算法的有效性。

0引言

学生评教留言经过逐年累积,已经形成一个巨量的信息资源,对其进行数据挖掘已经成为刻不容缓的工作,如何更好地利用大量的留言体现了一个学校对其教学水平和方法进行提升和改进的能力,一个高水平的学校应积极发展对学生留言的挖掘,对其进行分析、处理并最后得出结论,及时了解和分析教师的教学现状和学生们的听课反馈。

国内外相关学者对文本倾向性分析进行了大量研究[15],虽然英文的倾向性研究已经很成熟并得到了丰硕成果[617],但是中文文本的倾向性研究还处在发展阶段,有着广阔的发展空间。柴玉梅等[1]通过分析中文文本内容褒贬色彩的客观性和褒贬倾向性分类的可行性,将特征选择方法和褒贬特征提取技术结合起来,实现了名人网页的褒贬倾向性分类;唐慧丰等[2]通过对中文文本不同分类方法的对比分析,提出采用BiGrams特征表示方法、信息增益特征选择方法和SVM分类方法,在足够大训练集和选择适当数量特征的情况下,在情感分类方面取得较好的效果;Tan等[6]针对中文文本,通过对四种特征选择方法和五种学习方法进行实验,提出信息增益特征选择方法与SVM进行组合,能够得到较好的预测结果;Prabowo等[7]提出一种规则分类、监督学习和机器学习相结合的方法,能够对电影评论、产品评论和MySpace留言进行倾向性分析;Li等[8]提出结合Kmeans聚类算法和SVM来实现无监督学习的方法,并利用此算法进行在线论坛热点的侦探和预测。

Tan等[6]针对中文文本,通过使用MI(Mutual Information)、IG(Information Gain)、CHI(CHI Statistics)和DF(Document Frequency)四种特征选择方法和质心分类、K近邻、Window分类、贝叶斯分类、支持向量机五种分类方法进行实验,提出信息增益特征选择方法与SVM进行组合,得到较好的预测结果,但是其只是针对1 021个文本数据进行实验,并未能够将其应用到学生评教留言中,学生评教留言具有一定的特殊性,它是对教师教学活动的评价,其中含有对教师丰富的情感,并非只是对一件物品的评价。针对学生评教留言,本文提出了一个学生评教留言的倾向性分析算法。首先,利用ICTCLAS对2 500条留言文本进行分词,其次,进行词性过滤,保留名词、动词、形容词和副词四类词语,再次,进行词语过滤,使用基于频率、信息增益、条件概率比和期望值差异四种方法进行实验,然后,生成词频矩阵,并将矩阵进行奇异值分解、降维、去除冗余数据操作,最后,利用SVM将生成的矩阵进行训练和预测。本文特别针对学生评教留言,为实际的教学评价活动提供一定的决策支持,能够生成较好的预测结果,使得此算法能够更好地应用于实际的教务系统和教学活动中。

1算法流程

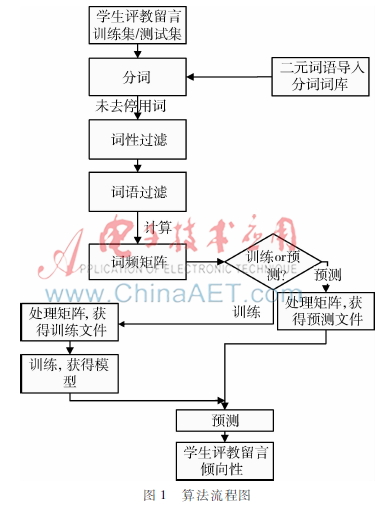

本文特别针对学生评教留言,提出一种基于期望值差异的词语过滤方法与支持向量机相结合的倾向性分析算法,算法流程如图1所示。

算法流程如下:

输入: 500条留言作为训练数据, 2 060条留言作为预测数据。

输出:2 060条预测数据的倾向性结果,以及本算法的正确率和拒识率。

(1)分词。用ICTCLAS50分别对训练数据和预测数据进行分词。

(2)词性过滤。保留名词、动词、形容词和副词四类词性词语。

(3)词语过滤。利用基于频率、信息增益、条件概率比和期望值差异的过滤方法对词语进行过滤。

(4)生成词频矩阵。以“词项×文档矩阵”的格式生成词频矩阵。

(5)矩阵处理。获得训练文件,对矩阵进行奇异值分解、降维、去除冗余数据后生成训练文件。

(6)训练。用LIBSVM对训练集进行训练,获得训练模型。

(7)预测。将预测集导入LIBSVM,利用上一步获得的训练模型进行预测。获得倾向性结果,计算本算法的正确率和拒识率。

2学生留言的倾向性分析

2.1学生留言的预处理

2.1.1训练数据的选取

训练数据的质量直接决定预测的效果,训练数据是需要精挑细选的一些留言数据,必须具有良好的分类代表性,选取遵循以下原则:

(1)需要过滤掉所有空留言、只含有标点符号的留言以及不包含任何词语的文本。

(2)重复性留方过滤。完全重复的留言,以及留言文字相同但是有标点符号不同的文本需要删除,因为它们的向量基本相同。向量相同的留言放到libsvm中处理只会增加计算量。

(3)训练数据中各类的数目要大体相当。

(4)删除部分表达意思相近的留言。

(5)训练数据不宜选取过多,也不宜过少,如果过多就会存在很多重复性的向量,如果过少,训练集太小,不能很好地进行预测。训练集的大小在500条左右即可。

基于以上选取数据的原则,本文从数据库中抽取了500条数量相当的差评留言和好评留言。

2.1.2双重否定短语的确定

一般情况下,一条留言中出现否定词就会被判定为差评。例如:“讲课太过于粗糙,条例不太清晰”,这样的留言中含有“不”,会被判定为差评,这样进行判定看似是理所当然的,实则不然,例如留言“注意启发学生课外阅读,不拘泥于课本,能调动学生积极性,活跃课堂气氛”,其中含有“不”,但是“不”后面跟的是“拘泥”,在语言中,双重否定表达的是肯定意思,根据语义分析这是好评,但是训练器把它标记成差评了,这样不符合客观事实。为了解决这个问题,本文把两个表达否定意义的词语组合成一个短语,形成一个表示肯定意义的短语,优先对这些组合起来的二元词语匹配,并在后续处理过程中把这些短语当做一个词语对待。

在留言中经常出现的双重否定词语包括:不拘泥、不单纯、不忘、不脱离、不失、不死、不死板、不拘于、不枯燥、不只、不少、不错、不容易等等。

2.2特征词的四种选择标准

2.2.1基于频率的过滤方法

基于频率的过滤方法中,一条留言中一个词语出现一次以上都是按照一次计算。本文采用了长匹配优先的方式对其进行匹配。如果一个词语包含另一个词语,则被包含的词语的次数不能加一,例如第一条留言中出现“清楚”,包含“清”,第二条留言中包含“清”,则“清”出现的次数只能是一次,而不是两次,还有一种特殊情况是“松”被分作了两个词性,“松/a”和“松/ng”,对于这种情况需把所有词语的词性去掉之后再统计这个词语出现的次数。去掉出现频率低于二次的留言之后,还剩下407个词语。

2.2.2基于信息增益的过滤方法

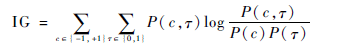

基于信息增益的过滤方法中,根据IG计算公式计算需要留下的IG值:

c表示类别,属于此类或者不属于;τ表示此特征出现与否,布尔型。若特征与类别无关,则IG=0。按照IG值的大小排序,获取IG值较大的407个词语。

2.2.3基于条件概率比的过滤方法

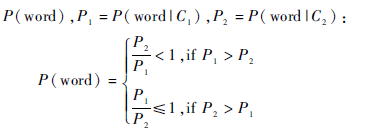

基于条件概率比的过滤方法,根据下面公式计算P(word),P1=P(word|C1),P2=P(word|C2):

在这里P(word)越小越有意义,说明word在不同类别中出现的概率差异大。若P1/P2=1或者P2/P1=1,则说明word的出现与类别判断无关,可去掉;若P1/P2=0或者P2/P1=0,则说明word的出现与类别高度有关,此类词语需保留。

2.2.4基于期望值差异的过滤方法

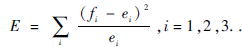

基于期望值差异的过滤方法,其具体计算方法是:一个词项word在类i中出现的期望值ei=word在所有数据表中出现的总次数×P(Ci),令fi表示word在类i中出现的实际次数,则

其中E的值越大越有意义。

3实验结果分析

在Intel双核CPU、主频3.06 GHz、内存2 GB的台式机上实现一个实例,来验证本文算法的有效性。

3.1数据集

本文使用山东女子学院教务系统2011年评教数据作为数据来源,原始数据来源于教务系统中的学生留言,共计3 000条。由于这些数据包含无意义数据,经过筛选,从前1 000条数据中选出500条作为训练数据集,预测数据集为从后2 000条中筛选出的1 309条数据。

3.2训练

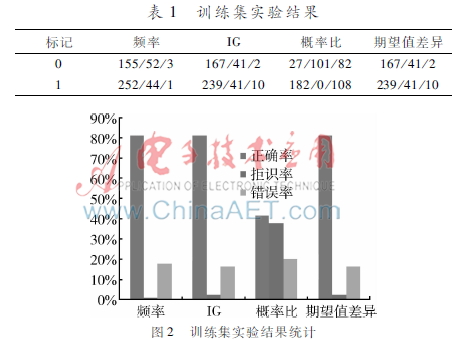

本文基于真实数据集,利用四种词语过滤算法,使用SVM进行训练。训练结果如表1和图2所示,表1中标记为“0”的训练结果为负面评价,标记为“1”的训练结果表示为正面评价,每个单元格中的三个数字分别表示正确率、错误率和拒识率。

从表1和图2可以看出,基于频率的过滤方法、基于信息增益的过滤方法、基于期望值差异的过滤方法训练数据的正确率达到了80%以上,错误率都低于20%,但是基于条件概率比的过滤方法正确率不到50%。从这些数据来看,针对学生评教留言文本,选择基于频率、信息增益、期望值差异的词语过滤方法能够达到较好的效果。

3.3预测

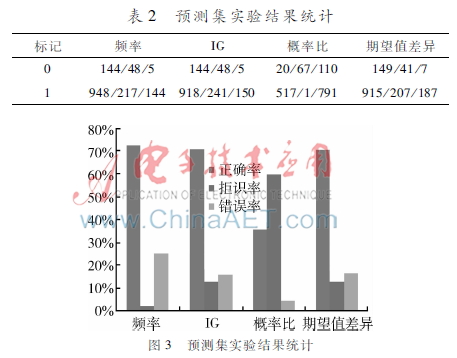

预测结果如表2和图3所示,表2中标记为“0”的训练结果表示为负面评价,标记为“1”的训练结果表示为正面评价,每个单元格中的三个数字分别表示正确率、错误率和拒识率。

从表2和图3可以看出,基于频率的过滤方法、基于信息增益的过滤方法、基于期望值差异的过滤方法预测数据的正确率达到了70%以上,错误率都低于30%,基于期望值差异的过滤方法错误率低于20%,与其他三种算法相比,基于期望值差异的词语过滤算法效果最好。从这些数据来看,针对学生评教留言文本,基于期望值差异的词语过滤算法与SVM结合能够达到较好的效果。

4结论

本文特别针对高等学校学生评教留言,通过实验研究了基于频率、信息增益、条件概率比、期望值差异的四种词语过滤方法与支持向量机结合,最终给出文本倾向性结果的效果,通过对比分析,得出基于期望值差异的词语过滤方法与支持向量机结合的算法,能够对学生评教留言的倾向性给出较优的预测结果。

参考文献

[1] 唐慧丰. 基于监督学习的中文情感分类技术比较研究[J].中文信息学报, 2007,21(6):8894.

[2] 柴玉梅,熊德兰,昝红英. Web文本褒贬倾向性分类研究[J].计算机工程, 2006,12(9):8991.

[3] 杨超,冯时,王大玲,等.基于情感词典扩展技术的网络舆情倾向性分析[J].小型微型计算机系统, 2010,31(4):691695.

[4] 何凤英.基于语义理解的中文博文倾向性分析[J].计算机应用, 2011,31(8):21302137.

[5] 李艳红,程翔.基于网络论坛文本挖掘的笔记本电脑满意度研究[J].微型机与应用,2014,33(18):6165.

[6] TAN S,ZHANG J.An empirical study of sentiment analysis for Chinese documents[J].Expert Systems with Applications, 2008,34(4):26222629.

[7] PRABOWO R, THELWALL M. Sentiment analysis: a combined approach[J]. Journal of Informetrics, 2009,3(2):143157.

[8] LI N, WU D D. Using text mining and sentiment analysis for online forums hotspot detection and forecast[J]. Decision Support Systems, 2010,48(2):354368.

[9] STEFANO B,ANDREA E, FABRIZIO S.SentiWordNet 3.0: an enhanced lexical resource for sentiment analysis and opinion mining[C]. Proceedings of the Seventh Conference on International Language Resources and Evaluation. Malta:European Language Resources Association ,2010:22002204.

[10] PANG B,LEE L.Opinion mining and sentiment analysis[J]. Foundations and Trends in Information Retrieval, 2008,2(12):131135.

[11] ERIK C,BJORN S, YUNQING X, et al. New avenues in opinion mining and sentiment analysis[J]. IEEE Intelligent Systems, 2013,2(28):1521.

[12] LIU B,ZHANG L. A survey of opinion mining and sentiment analysis[M].New York:Springer US, 2012.

[13] THERESA W,JANYCE W, PAUL H. Recognizing contextual polarity in phraselevel sentiment analysis[C]. Proceedings of the conference on Human Language Technology and Empirical Methods in Natural Language Processing. Stroudsburg:Association for Computational Linguistics, 2005:347354.