肖景芬,夏斌

(上海海事大学 信息工程学院,上海 201306)

摘要:由于身体原因导致无法进行语音交流的群体越来越受到大家的关注,为了这部分群体能重新使用语音交流,科研工作者们进行了各种尝试性研究。以前的研究主要围绕着肌电信号与语音信号间的映射关系,而本文是通过深度神经网络建立语音信号与脑电信号间的映射关系。将从语音中提取的特征作为前馈神经网络的输入,将脑电信号的特征作为输出目标建立模型。对回归预测的模型使用R-square进行评估,R-square的值达到了0.75。

关键词:语音信号;脑电信号;回归预测;深度神经网络

0引言

语音是人类最方便、最自然的交流方式。但是对于那些失语,不方便直接进行语音交流的特殊人群,这种交流方式就变得十分困难了。不少科研人员对此进行了研究。JOHNER C等人[1]利用获取的肌电信号训练模型,从而判断正常的语音中句子的正误,并且区分语音中正常的词语和强调的词语。而在参考文献[2]中,JANKE M等人使用深度神经网络建立从脸部的肌电信号到语音信号的转换关系。此文具有很大的参考意义。文中提出了直接从肌电信号到语音信号的映射方法,从多个肌电信号通道中提取特征,通过前馈神经网络[3],实现了输入肌电信号输出语音。文中还对输出的语音信号进行了两种方式的评价:MelCepstral Distortion[4] 得分和人为听语音评分[5]。参考文献[6]中使用了电磁关节造影术采集数据,提取特征合成语音信号。

上述研究中主要从肌电信号出发,研究语音信号和肌电信号之间的关系。而本文从另外一个角度——脑电信号数据出发,研究语音信号和脑电信号(EEG signals)之间的关系。本文分别对语音信号和脑电信号提取特征,建立语音信号与脑电信号特征间的映射关系,最后使用R-square方法评估此回归映射模型效果。

1方法概述

深度神经网络是一种多层判别模式模型,每层都是由多个神经元组成的。模型的底层是可见的输入层h0,接下来是L层的隐藏层h1,h2,…,hL,最后一层是输出层hL+1。此处考虑的是全连接的前馈深度神经网络:前一层中每个神经元都和下一层的神经元连接着,同一层的神经元间没有连接。在训练过程中,模型学习到连接权重矩阵,通常是使用后向传播(BP)算法。w(l)i,j表示l-1层的神经元i连接l层神经元j的权重值。对比简单的神经网络,深度神经网络具有多于2层的隐藏层。

对于每一层的每个神经元i,除了输入层都有一个激活函数σ和一个偏置量bi,神经元和权重相乘后,将其结果作为激活函数的输入得到的就是神经元的输出结果。对于l层神经元i的输出等式为:

其中nl-1是hl-1层的神经元数目。

使用深度神经网络处理回归预测问题时,它的输入神经元是输入数据的值,通过训练整个模型,让输出层的输出值拟合输出数据值。具体细节可以查看参考文献[7]。

深度神经网络(DNN)训练通常是复杂的难题,因为如果初始化权重较大的话通常会导致较差的局部最优值,而较小的初始化权重得到的梯度较小,这样在训练多个隐藏层时行不通[8]。通常使用BP算法来训练整个网络,一般选择连续添加各层网络。首先,网络只由输入层 h0、第一个隐藏层h1,最后是输出层hL+1组成。初始网络模型是随机初始化,使用BP算法进行精调。然后,加入下一层,这样新的网络模型有输入层h0,接着是两个隐藏层h1、h2,最后是输出层hL+1。从输入层h0到第一个隐藏层h1的连接权重矩阵就是刚才训练得到的权重矩阵,其他的权重仍然是随机初始化得到的。然后利用BP算法进行网络模型的精调。整个处理过程一直重复,直到所有的隐藏层都被添加进网络模型中。输入和输出数据在加入网络模型前进行了zscores归一化处理。

在每一步中权重都是使用均值为0.000 1、方差为1的标准高斯分布进行随机初始化。预测值和实际值间使用均方误差(MSE)作为误差标准。

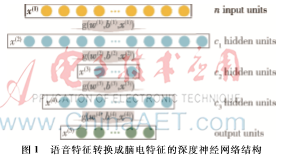

图1显示了使用的五层神经网络结构,用于建立语音信号特征与脑电信号特征间的映射关系。

训练神经网络模型建立脑电信号特征和语音信号特征映射关系,即如果G(xi)表示映射,则映射的误差为:

此处,w(n)和b(n)分别表示隐藏层和输出层的权重矩阵和偏置矩阵。ReLu[9]表示Rectified Linear Units激活函数,ReLu(x)=max(0,x)。

2实验数据及其处理

本文用到的数据集是图宾根大学采集的受试母语为意大利语的语音和脑电信号。实验过程中一边播放语音信号,一边采集受试者的脑电信号。脑电信号有12个通道的数据,信号的采样率为200 Hz。每段语音信号的长度都不一样。在播放的句子中有正确的和错误的,本研究中取的是正确的句子。对于每个语音信号都取出对应的脑电信号。

对于每个语音和脑电信号样本都作光滑处理,语音信号和脑电信号处理方法一样。以语音信号处理方法为例,为了处理语音信号,需要对语音信号进行加窗,也就是一次仅处理一个窗中的数据。因为实际的语音信号比较长,不能也不必对非常长的数据进行一次性处理。实际解决方法就是每次取一段数据进行分析,然后再取下一段数据进行分析。本文中选用的是汉明窗进行数据截取。它主要部分的形状类似于sin(x)函数在0~π区间的形状,而其他部分都是0。这样的函数乘上其他任何一个函数f,f只有一部分有非零值。因为会对汉明窗中的数据进行FFT处理,假设一个窗内的信号代表一个周期的信号,这样窗的左端和右端应该大致能连在一起。而通常一小段音频数据没有明显的周期性,加上汉明窗后,数据形状就有周期感。但是加上汉明窗后,只有中间的数据体现出来,而造成两边的数据信息丢失,所以移窗的时候,只会移窗口部分数据,这样被前一帧或两帧丢失的数据又重新得到体现。

本文中语音信号和脑电信号取0.2 s的数据作为一个小样本,滑动窗口为0.01 s。这样一段语音信号中就包含了多个小样本。同样的一段脑电信号中也包含了多个小的脑电信号样本。由于脑电信号和语音信号采样率相差过大,每段语音信号及对应脑电信号在滑动窗口后划分的小样本数有时会相差1(由于采样率乘以窗口时长不是一个完整的样本,因此舍去),最终语音信号和脑电信号的样本数不相等。在每段语音信号和对应的脑电信号划分的小样本过程中,都取样本数中的最小值处理。比如某段语音信号有33个小样本,而脑电信号只有32个小样本,就取语音信号的前32个样本和脑电信号的前32个样本。经过上述处理后,整个数据集样本数为6 601。对于语音信号和脑电信号样本都进行短时傅里叶变换预处理。数据预处理后语音数据集维度为6 601×4 411,脑电信号数据集维度为6 601×252。将数据集进行28分后,使用前馈深度神经网络进行建模。输入为语音特征数据,脑电特征数据作为输出。神经网络的隐藏层结构为800、500、300,学习率为0.001,迭代次数为300。

3实验结果

回归预测结果评估方法[10]有SSE(误差平方和)、MSE(均方差)、RMSE(均方根误差)、Rsquare(确定系数)。SSE计算的是预测数据和原始数据对应点的误差平方和;MSE计算的是预测数据和原始数据对应点误差平方和的均值,即MSE=SSE/n;RMSE即回归系统的拟合标准差,是MSE的平方根;SSR为预测数据与原始数据均值之差的平方和;SST为原始数据与原始数据均值之差的平方和。它们之间的关系为:SST=SSE+SSR,Rsquare=SSR/SST。

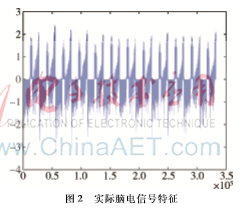

Rsquare可以直接表示拟合的模型是否描述数据。而SSE、MSE、RMSE则必须和数据本身进行对比之后才有价值。因为如果数据值本来就很小,SSE、MSE、RMSE的值也会很小,这样就失去了原本用来评估回归模型的意义。而Rsquare是通过数据的变化来表征一个拟合的好坏,不会受数据值大小影响。由上面的表达式可以知道Rsquare的取值越接近1,表明方程的变量对因变量的解释能力越强,训练模型对数据拟合得也较好。所以在本文中使用Rsquare评估训练模型,前馈深度神经网络训练模型的Rsquare值为0.750 732 868 52。图2、图3分别展示了脑电信号特征的预测值和实际值。

图2和图3为分别对脑电信号特征的预测值和实际值做处理后的结果。由于所做的回归预测是高维数据的回归预测,如果直接画图的话,数据都堆在一起无法展示出效果,因此把1 320×252维的预测脑电信号特征数据整理成332 640×1维的数据,即把所有列的数据展开。从图中可以明显看出脑电信号特征预测值和实际值的相似性。

4结论

本文的语音到脑电信号特征的转换回归预测实验得出了比较好的结果。尽管不能直接看到回归预测得到的语音信号,但是结果表明脑电和语音之间确实有着一定的关联,这对于失语病人或直接语音交流不方便但思想正常的病人来说,以后重新通过语音交流不再是梦想。接下来的工作是通过更好地处理实验数据以及进一步地将脑电特征直接转换为语音信号,实现直接的脑电信号转换为语音信号输出。

参考文献

[1] JOHNER C, JANKE M, WAND M, et al. Inferring prosody from facial cues for EMG-based synthesis of silent speech[C]. Proceedings of 4th International Conference on Applied Human Factors and Ergonomics, 2012:5317 5326.

[2] JANKE M, SCHULTZ T. Direct conversion from facial myoelectric signals to speech using deep neural networks[C]. International Joint Conference on Neural Networks, 2014:1 7.

[3] BEBIS G, GEORGIOPOULOS M. Feed forward neural networks: why network size is so important[J]. IEEE Potentials, 1994(4):27 31.

[4] KUBICHEK R F. Mel cepstral distance measure for objective speech quality assessment[C]. IEEE Pacific Rim Conference on Communication Computers and Signal Processing, 1993:125 128.

[5] KRAFT S, ZLZER U. BeaqleJS: HTML5 and JavaScript based framework for the subjective evaluation of audio quality[C]. Linux Audio Conference, 2014.

[6] BOCQUELET F, HUEBER T, BADIN P, et al. Robust articulatory speech synthesis using deep neural networks for BCI applications[C]. Interspeech 2014, 15th Annual Conference of the International Speech Communication Association, Singapour, 2014.

[7] LAROCHELLE H, BENGIO Y, LOURADOUR J, et al. Exploring strategies for training deep neural networks[J]. Journal of Machine Learning Research, 2009:10(10):1 40.

[8] HINTON G E, SALAKHUTDINOV R R. Reducing the dimensionality of data with neural networks[J]. Science, 2006,313(5786):504 507.

[9] GLOROT X, BORDES A, BENGIO Y. Deep sparse rectifier neural networks[C]. 14th International Conference on Artificial Intelligence and Statistics, 2011:315 323.

[10] HYNDMAN R J, KOEHLER A B. Another look at measures of forecast accuracy[J]. International Journal of Forecasting,2006,22(4):679 688.