张兆丰,吴泽民,杜麟,胡磊

(中国人民解放军理工大学 通信工程学院,江苏 南京 210007)

摘要:针对目标在图像边界上带来的检测误差,提出了边界显著性算法。首先在多尺度下对图像进行超像素分割,计算边界差异,估计其边界显著性。而后对所有超像素进行模式挖掘,得到显著性种子,并与边界显著性相结合。最后通过显著性传播得到最终显著图。在三个公开的测试数据集上将本文提出算法与其他18种主流的现有算法进行对比。大量实验结果表明,所提出的算法在不同数据集上都优于目前主流算法。

关键词:边界显著性;多尺度;模式挖掘;显著性种子;显著性传播

中图分类号:TN919.85文献标识码:ADOI: 10.19358/j.issn.1674-7720.2017.08.012

引用格式:张兆丰,吴泽民,杜麟,等.边界显著性与模式挖掘[J].微型机与应用,2017,36(8):34-38.

0引言

*基金项目:国家自然科学基金(61501509)近年来,计算机视觉受到了众多学者的关注,显著性检测作为降低计算复杂度的重要预处理过程,更是被广泛应用于目标识别、目标跟踪以及图像分割等相关领域。

显著性检测被划分为两个领域:一是眼动点预测,这一类模型被广泛应用于生物学、神经学等认知领域。另外就是本文所讨论的显著性目标检测。通常又将显著性目标检测分为两类:自顶向下的任务驱动方法,针对目标的高级特征信息,通过大量样本的训练进行检测。与之相反,自底向上的数据驱动方法通常利用颜色、纹理以及空间分布等低级特征获取显著图。早期的一些方法基于中心优先,通过计算目标与其周围环境对比度得到显著图。自从Wei Yichen[1]首先提出利用图像边界作为背景的思路后,越来越多的算法采用背景优先或边界优先,并取得了较好的检测效果。这类方法通常将边界区域作为背景,虽然大多数情况下图像边界很有可能成为背景,但是对于传统的背景优先算法将所有的边界归为背景并不合理。

本文主要针对上述问题,提出边界显著性,并与模式挖掘相结合,从而同时利用目标和边界特征,更好地将多特征整合。最终得到的结果优于其他先进算法。

1相关工作

早期的一些图像显著性检测算法,通常是基于中心优先。这一类算法大多从图像中显著目标与背景区域对比度差异的角度出发,计算局部或者全局对比度。但是基于对比度的中心优先算法存在以下缺陷:首先对于局部对比度,目标的边缘区域与背景特征差别较大,对比度自然较高,但是目标内部对比度相差不大的,反映到最终的显著图上很容易造成目标相对清晰高亮,而内部模糊不清,整体性较差。而对于全局对比度,当背景特征与目标相似时误检的可能性较高。而且基于中心优先的算法对目标的所在位置与尺寸大小有较强的针对性,对于大尺寸目标和目标在边界上这类情况,检测效果往往较差。

区别于中心优先,近来,越来越多的显著性检测算法利用背景优先构建显著图。Wei Yichen最早提出背景优先这一概念,将图像边界默认为背景,对分割后的图像,计算分割块到边界的测地线距离来衡量其显著性。文献[2]在此基础上提出了边界连通度这一概念,并给出了可以推广到其他模型上的优化算法。诸如此类的背景优先算法大多有一个共同的缺陷,对于所有边界都不加区分地作为背景对待,因此对于目标在边界上这类情况,检测效果没有从根本上得到提升。

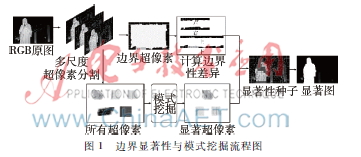

为了更好地解决目标在边界上带来的一系列问题,本文提出了一种边界显著性算法,并与模式挖掘相结合。图1为本文算法流程图,首先对输入图像在多尺度上进行超像素分割,而后对所有边界计算边界差异,从而估计其边界显著性。同时对所有超像素进行模式挖掘,得到显著性种子,并结合边界显著性结果,对得到的种子加以显著性传播,最终得到显著图。

2图的构建

目前超像素分割已经融入到计算机视觉、模式识别等各个研究领域。利用超像素作为图像处理的基本单元,大幅度降低了直接处理像素的算法复杂度。本文选取了简单线性迭代聚类(Simple Linear Iterative Clustering ,SLIC)[3]进行超像素分割,不仅基本保留了图像原本的结构化信息,而且使得到的区域如同细胞一样排列比较紧凑规整,可以把以前基于像素的方法加以改造后应用,统计特征也比较好保持。

对于一般图像而言,图像中的物体尺度各不相同,待检测的显著目标也就会有多种尺度。因此最终的显著性检测的结果与超像素的数量是有很大关系的,如果从单一尺度进行显著性检测,很有可能导致最终检测不准确。为了最大程度降低尺度上带来的影响,本文在三个不同尺度上对图像进行分割,超像素个数分别是300,400和500。以超像素V为节点,邻接超像素之间为边E,构造一个无向加权图G=(V,E)。相邻节点间权重定义如下:

其中ci和cj分别代表节点i和j在CIELab色彩空间上的平均颜色值,ci-cj代表两个节点在CIELab色彩空间上的欧氏距离。σ是权重控制参数,反映了超像素之间的差异,一般手动设置其大小。当图像中颜色差异较大时,σ的值相应较大;当图像整体颜色差异较小时,σ的值相应较小。参照文献[4]依据超像素颜色的差异来自适应计算σ值:

![5AT9J$]]V34QK(KFSEX~[PR.png 5AT9J$]]V34QK(KFSEX~[PR.png](http://files.chinaaet.com/images/2017/05/27/6363147477324152453000037.png)

其中,m=14N2s∑Nsi,j=1ci-cj,Ns 表示超像素的总数。

3边界显著性与模式挖掘

3.1边界显著性

现有的显著性检测算法对于普通的目标与背景区分效果较好,但是当目标的一部分位于边界上时,如图2所示,很多基于背景优先的算法也无法给出较好的检测结果。这是由于传统基于背景优先的检测算法没有对边界加以区分,直接把所有边界都当作背景处理所导致的。因此本文提出了边界显著性这一概念,对边界上目标出现的可能性进行估计,从而提升最终检测效果。

通过对大量图像样本的统计发现,对于目标在边界上的图像,如果把所有边界超像素视为一个连通区域,大多数情况下只有相对较小的一部分是显著目标,而且显著目标和背景往往在颜色分布上有着明显的区别。因此借鉴文献[5]、[6],在RGB色彩空间上分别计算边界的像素分布。

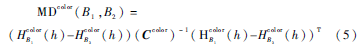

其中B={top, bottom, left, right}代表图像的四条边界,h=0,1,2,…,255代表不同的亮度区间,NB代表边界连通区域像素总数,Ip代表像素p的亮度,δ(·)表示单位脉冲响应函数。然后计算边界像素分布间的马氏距离(Mahalanobis Distance, MD),构造边界差异矩阵:

其中MDcolor(B1,B2)表示在不同颜色通道下,边界B1和B2之间的马氏距离。color=

其中Ccolor表示在不同颜色通道下的协方差矩阵。得到4×4的边界差异矩阵D,将矩阵每一列元素加和,最终得到每条边界与其他边界的差异度:

dn=∑4m=1D(Bn,Bm)(6)

以负指数函数估计边界上存在目标的概率从而表示边界显著性:

S(Bn)=1-exp(-(dn/dmin-1))(7)

其中dmin=min{di}i=1,…,4为差异度最小的边界,即边界上存在目标的可能性最小,因此边界显著性为0。其余边界差异度越大,目标在边界上的可能性就越大,与之对应的边界显著性越大。

3.2基于边界显著性改进的模式挖掘算法

模式挖掘最早应用在市场营销分析,近年来逐渐被应用到计算机视觉领域。文献[7]利用模式挖掘,在先验显著图的基础上寻找可靠的种子节点:

supp(A)>t1

conf(A→pos)>t2(8)

其中supp(·)代表支持度,conf(·)代表置信度,A代表频繁项集,pos代表正样本(即显著)标签,t1和t2分别是支持度和置信度的筛选阈值参数,根据文献[7]分别设置为90%和20%。最终得到的显著性种子集合记为L。f={f1,f2,…,fNs}T代表节点标签向量,结合第3节中提到的边界显著性,对f初始化如下:

![628W]$AC{BSKY7G1%3U9W@A.png 628W]$AC{BSKY7G1%3U9W@A.png](http://files.chinaaet.com/images/2017/05/27/6363147483119885302494056.png)

对于模式挖掘得到的显著性种子,初始化为1;对于不是显著性种子但位于边界上的节点,按其边界显著度初始化;对于其他节点则初始化为0。

而后利用随机游走模型进行显著性传播:

![K]ZL4T7108$LCCE`8867IVY.png K]ZL4T7108$LCCE`8867IVY.png](http://files.chinaaet.com/images/2017/05/27/6363147483816810808077138.png)

公式(10)~(12)分别代表随机游走(Random Walking, RW)、拉普拉斯算子(Laplacian, La)、先验显著图(Priori Saliency, PS)。N(i)代表节点i的邻接节点,yi代表先验显著图中节点i的显著值,α和β 是权重控制参数,分别取值0.5和0.01。

argminf{RW+La+PS}

s.t.fi=1,i∈L(13)

公式(13)中分别考虑了传统的随机游走、二次拉普拉斯算子、先验显著图对于最终显著检测结果的影响。

4实验结果

4.1实验设置

测试数据集:本文在3个公开数据集对提出的算法进行测试,并与其他18种显著性检测模型做横向比对。下面分别说明本文使用的3个数据集的不同特点。

MSRA:1 000张图像,含有像素级的真值标准,大部分图像为单一目标,但是很多图像中目标在边界上,存在一定的挑战性。

SED2:100张图像,含有像素级的真值标准,虽然图像规模较小,但是所有图像都存在两个目标,并且大多数目标位于边界上,挑战难度很大。

ECSSD:1 000张图像,含有像素级的真值标准。背景比较复杂,存在很多大尺度目标而且有很多位于边界上的目标,挑战难度很大。

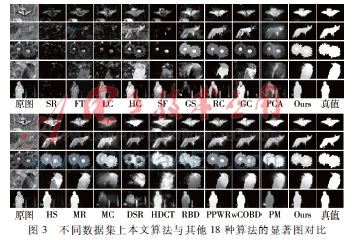

对比算法:SR,FT,LC,HC,SF,GS,RC,GC,PCA,HS,MR,MC,DSR,HDCT,RBD,RRWR,wCOBD和PM。其中GS[1],MR[8],MC[9],DSR[10],RBD[2]和wCOBD[11]为近年来比较优秀的基于背景优先的显著性检测算法。

评价指标:为了更加全面地衡量本文提出算法的检测性能,通过准确度召回率(PrecisionRecall,PR)曲线、Fmeasure、平均绝对误差(Mean Absolute Error,MAE)和AUC(Area Under ROC(Receiver Operating Characteristics,接收者操作特性) Curve,ROC曲线下面积)对所有算法进行评价。

本文所有试验都是在MATLAB平台上实现的,所应用的计算机配置为Intel E52620,CPU 2 GHz,96 GB RAM。

4.2定性分析

图3展示了包括本文所提出的算法在内共19中显著检测模型最终生成的显著图。其中既包含了经典的中心优先算法,也包含了近年来优秀的背景优先算法。选取了不同类型的图像作为示例加以说明。对于第一个检测样本,目标表现出不同的颜色特征(蝴蝶翅膀黑白相间),一些算法不能很好地给出完整一致的目标整体,而且图像边界上存在干扰目标。对于第二个检测样本,背景区域和前景目标颜色区分较小,导致一些基于颜色对比度的检测算法检测失败。对于第三个检测样本,目标内部颜色对比度明显,导致部分算法对目标整体性估计不足(大多只能较好地检测黄色花蕊,但是对于红色花瓣检测效果欠佳),而且背景区域存在小尺度噪声。第四和第五个检测样本显著目标均位于边界上,而且在第五个检测样本中背景区域存在其他干扰目标,导致部分算法对于边界目标显著性估计不足。

本文算法由于结合了边界显著性与模式挖掘,在原有基础上加强了对边界信息的处理能力,而且由于在多尺度上计算,很大程度上避免了不同尺度噪声带来的影响。对于不同场景检测效果较好,鲁棒性较强。

4.3定量分析

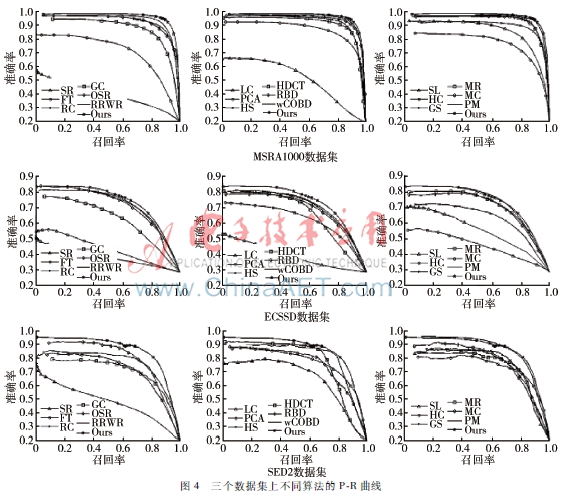

本文首先利用P-R曲线对所有算法进行评价。在计算机视觉领域,P-R曲线是一种常用指标。首先将得到的图5三个数据集上不同算法的Fmeasure曲线显著图量化到[0,255 ]区间内,按照一定的阈值分割得到二值图,然后参照真值图,计算准确度和召回率。

如图4所示,在三个数据集上测试结果显示,本文所提算法与其他算法相比,检测结果表现较好。

通常准确度和召回率难以同时保证,为了综合评价显著图的质量,本文采用Fmeasure曲线进一步对所有算法进行评价。其实质是准确度和召回率的调和平均。

图5给出了本文算法与其他算法的F-measure曲线,可以看出本文算法整体上优于其他算法。

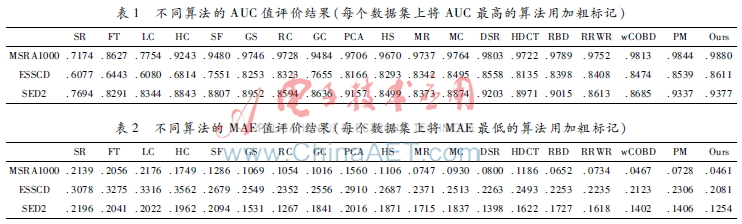

为了进一步对所有算法进行比较,还分别计算了不同算法的AUC。AUC值可以很好地反映不同算法的正确率和误警率。表1给出了不同算法的AUC值。

最后,用MAE来衡量显著图与真值之间的相似程度,其值在[0, 1]区间内,值越小代表性能越好。表2给出了所有算法的MAE值,反映出本文所提算法在不同数据集上都与真值更加接近。

从上述四种评价指标的结果来看,尤其是与GS,MR,MC,DSR,RBD和wCOBD这些基于背景优先的检测算法相比,本文算法性能有所提升,证明本文所提出的边界显著性的有效性,而且在不同数据集上均有相对较好的表现,证明了本文算法有较强的鲁棒性。

5结论

本文提出了边界显著性算法。在多个尺度上对图像进行处理,从而降低了目标尺度不同造成的检测误差。并与模式挖掘像结合,有效地解决了目前算法对于边界的显著性估计不足的问题。在三个数据集上,对本文所提模型与其他18种先进显著性检测模型进行对比,大量实验说明本文模型能够取得更好的检测结果,有较强的鲁棒性。

参考文献

[1] Wei Yichen, Wen Fang, Zhu Wangjiang, et al. Geodesic saliency using background priors[C]. 12th European Conference on Computer Vision (ECCV), Florence, Italy, 2012: 29-42.

[2] Zhu Wangjiang, Liang Shuang, Wei Yichen, et al. Saliency optimization from robust background detection[C].IEEE Conference on Computer Vision and Pattern Recognition (CVPR), Columbus, USA, 2014: 2814-2821.

[3] ACHANTA R,SHAJI A, SMITH K, et al. Slic superpixels compared to stateoftheart superpixel methods[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2012, 34(11): 2274-2281.

[4] 刘杰, 王生进. 融合聚类与排序的图像显著区域检测[J]. 清华大学学报(自然科学版), 2016(9):913-919.

[5] 杨雪. 基于视觉感知的图像显著区域的提取[J]. 微型机与应用, 2015, 34(2):47-48.

[6] LI Changyang, Yuan Yuchen,Cai Weidong, et al. Robust saliency detection via regularized random walks ranking[C]. IEEE Conference on Computer Vision and Pattern Recognition (CVPR), Boston, USA, 2015:2710-2717.

[7] Kong Yuqiu, Wang Lijun, Liu Xiuping, et al. Pattern Mining Saliency[C]. 15th European Conference on Computer Vision (ECCV), Amsterdam, Holland, 2016: 583-598.

[8] Yang Chuan, Zhang Lihe, Lu Huchuan, et al. Saliency detection via graphbased manifold ranking[C]. IEEE Conference on Computer Vision and Pattern Recognition (CVPR), Portland, USA, 2013. 31663173.

[9] Jiang Bowen, Zhang Lihe, Lu Huchuan, et al. Saliency detection via absorbing Markov chain[C]. IEEE Conference on Computer Vision (ICCV), Sydney, Australia, 2013: 1665-1672.

[10] Li Xiaohui, Lu Huchuan, Zhang Lihe, et al. Saliency detection via dense and sparse reconstruction[C]. IEEE Conference on Computer Vision (ICCV), Sydney, Australia, 2013: 2976-2983.

[11] Jiang Qingzhu, Wu Zemin, Tian Chang, et al. Salient object detection based on discriminative boundary and multiple cues integration[J]. Journal of Electronic Imaging, 2016, 25(1): 1-14.