亚马逊杀入AI训练芯片市场,产品性价比远超GPU

2020-12-02

来源:半导体行业观察

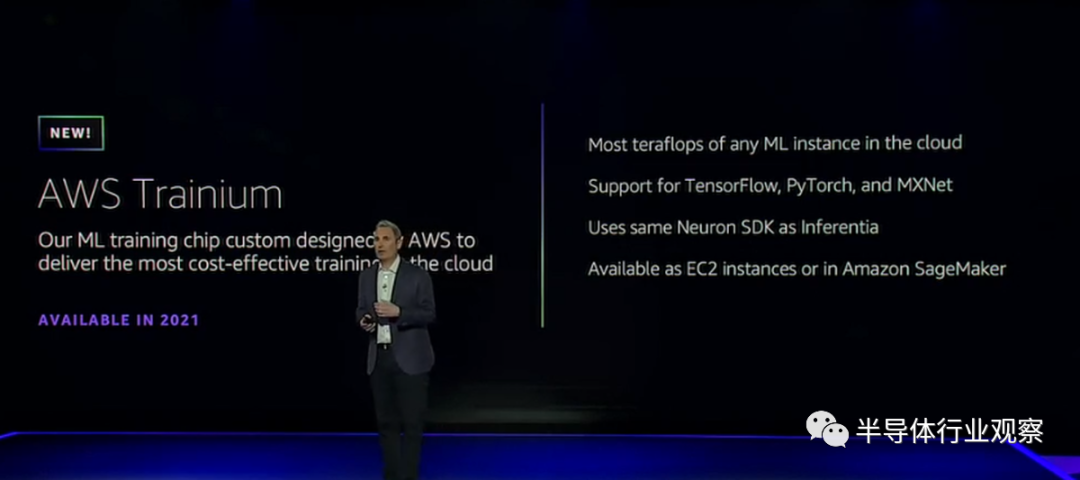

在近日举办的re:Invent开发人员大会上,AWS宣布推出全新的AI训练芯片AWS Trainium,这是该公司用于训练机器学习模型的下一代定制芯片。该公司承诺,通过对TensorFlow,PyTorch和MXNet的支持,它可以提供比云中任何竞争对手更高的性能。

据亚马逊方面介绍,AWS Trainium是由AWS设计的第二个定制的 机器学习(ML)芯片,为在云中训练ML模型提供最佳的性价比。除了提供最具成本效益的ML训练外,Trainium还为云中的ML提供了最高的性能和最大的万亿次运算(TFLOPS)计算能力,并支持更广泛的ML应用。

从他们提供的数据可以看到,亚马逊新芯片与标准的AWS GPU实例相比,带来了30%的吞吐量提升,并将每次使用成本降低了45%。

亚马逊指出,Trainium芯片专门针对深度学习培训工作负载进行了优化,适用于图像分类,语义搜索,翻译,语音识别,自然语言处理和推荐引擎等应用。

按照亚马逊的说法,随着ML的使用加速,我们迫切需要通过推理和训练来提高性能并降低基础架构成本。去年,AWS推出了AWS Inferentia,这是一种定制芯片,可为客户提供云中最低成本的高性能ML推理。虽然Inferentia解决了推理成本,即使该成本占ML基础架构成本的90%,但许多开发团队也还受到固定ML训练预算的限制。这限制了改进模型和应用程序所需的培训范围和频率。AWS Trainium通过为云中的ML培训提供最高的性能和最低的成本来应对这一挑战。借助Trainium和Inferentia,客户将拥有从扩展培训工作量到部署加速推理的ML计算的端到端流程。

亚马逊进一步指出,AWS Trainium与AWS Inferentia共享相同的AWS神经元SDK,这就方便Inferentia开发人员开始使用Trainium。由于Neuron SDK已与包括TensorFlow,PyTorch和MXNet在内的流行ML框架集成在一起,因此开发人员可以通过最少的代码更改轻松地从基于GPU的实例迁移到AWS Trainium。

据介绍,AWS Trainium可通过Amazon EC2实例和AWS Deep Learning AMI以及包括Amazon SageMaker,Amazon ECS,EKS和AWS Batch在内的托管服务使用。

因为没有基准测试结果,所以我们尚不清楚Trainium的性能在与Google的张量处理单元(TPU)进行比较时,谁更厉害。后者是Google托管在Google Cloud Platform中的AI训练工作负载的芯片。谷歌表示,即将推出的第四代TPU提供的矩阵乘法万亿次运算能力是第三代TPU的两倍以上。(矩阵通常用于表示输入到AI模型的数据。)它还提供了“显著”的内存带宽提升,同时受益于互连技术的进步。

过去,机器学习的部署受到算法的大小和速度以及对昂贵硬件的需求的限制。实际上, 麻省理工学院的一份报告发现,机器学习可能正在接近计算极限。一项单独的Synced 研究估计,华盛顿大学的Grover假新闻检测模型在大约两周内花费了25,000美元进行训练。据报道,OpenAI花费了高达1200万美元来训练其GPT-3语言模型,而Google估计花费了6,912美元来训练BERT,这是一种双向转换器模型,可为11种自然语言处理任务重新定义最先进的技术。

随着企业需求的增长,Amazon越来越倾向于转向AI和机器学习训练以及推理服务。根据一项估计,2017年全球机器学习市场的价值为15.8亿美元,预计到2024年将达到208.3亿美元。11月,亚马逊宣布将Alexa和Rekognition的部分计算转移到Inferentia支持的实例上,旨在使工作更快,更便宜,同时将其从Nvidia芯片上移开。当时,该公司声称将部分Alexa工作转移到Inferentia,从而使延迟时间缩短了25%,而成本却降低了30%。