Graphcore IPU性能首次超越英伟达再创新高

2021-12-30

作者:韦肖葳

来源:电子技术应用

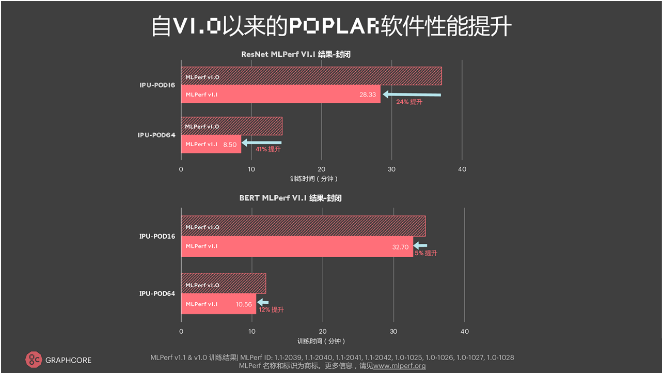

12月2日,AI芯片初创公司Graphcore(拟未科技)正式公布其参与MLPerf测试(MLPerf V1.1)的最新结果。Graphcore在本次提交了ResNet-50模型的Closed Division(封闭分区)以及BERT模型的Closed Division、Open Division(开放分区)。结果显示,与首次提交的MLPerf训练(MLPerf V1.0)结果相比,对于计算机视觉模型ResNet-50,Graphcore通过软件优化,在IPU-POD16上实现了24%的性能提升,在IPU-POD64上实现了41%的性能提升;自然语言处理模型BERT在IPU-POD16上实现了5%的性能提升,在IPU-POD64上实现了12%的性能提升。此次MLPerf测试结果证明了Graphcore的IPU系统越来越强大、高效,软件日益成熟且更快、更易使用。

Graphcore中国工程总负责人、AI算法科学家金琛指出,本次测试结果展现的性能显著提升主要归功于Graphcore对软件的优化,涵盖对应用程序、框架、系统、编译器、核函数的优化。“这些优化在不同模型上都有所体现。大家都知道,很多事情最开始的提升速度最快,但越往后提升越困难,通常需要80%的努力才能获得20%的提升。Graphcore能获得这些提升,我们是做了非常多的工作的。”她表示。

Graphcore中国工程总负责人、AI算法科学家金琛

纵向对比:首次纳入系统集群,ResNet-50在IPU-POD256上的训练时间只需3.79分钟

除了基于IPU-POD16和IPU-POD64提交的MLPerf V1.0测试,这一次,Graphcore首次纳入了系统集群,进行了128颗(IPU-POD128)以及256颗(IPU-POD256)IPU集群的提交。如图所示,ResNet-50在IPU-POD16上的训练时间(Time to Train)为28.33分钟,随着系统的增大,训练时间逐次递减——在IPU-POD64上的训练时间为8.5分钟,在IPU-POD256上只需3.79分钟。“希望明年此时,我们能提供更大的集群,让ResNet-50的训练时间在1分钟之内完成,这是我们的目标。”金琛表示。

上图显示的是Graphcore提交的BERT-Large在MLPerf上的性能表现。“我们在IPU-POD16上的端到端训练,在Closed Division上只需半个小时。如果把整个集群增大8倍,我们的训练时间不到7分钟。随着集群的增加,训练时间大幅缩短,这会极大提高算法工程师迭代模型的效率。在Open Division的提交方面,我们在IPU-POD64上的性能进一步提高,原因是IPU得到了优化,包括对训练策略、对训练优化器超参以及对损失函数的优化。如图所示,我们基本上另外提高了20%,这非常可观。这些优化我们也应用到了一些客户上,得到了正面反馈。”金琛指出。

横向对比:首次仅通过软件实现性能提升,IPU-POD16性能优于DGX A100

MLPerf同时对比了市面上Graphcore与NVIDIA的产品。尽管GPU在ResNet-50模型上占据优势,测试结果仍然显示Graphcore的IPU-POD16在ResNet-50方面的表现优于NVIDIA的DGX A100。值得注意的是,这是NVIDIA生态系统在MLPerf训练测试中的第五次亮相,而Graphcore是第二次提交。Graphcore的这次提交也是其首次仅通过软件实现了性能提升。在ResNet-50上,IPU-POD16首次超越了DGX A100的性能,其端到端的训练时间只用了28.3分钟,比DGX A100快了近一分钟。

如文章首段所提,IPU-POD16对ResNet-50的软件驱动性能提高了24%,在IPU-POD64上对ResNet-50的软件驱动性能提升甚至更高,达到41%,对于Graphcore具有里程碑式的意义。在金琛看来,NVIDIA的软件库已经迭代许久,提升的空间可能会有所减缓。Graphcore会持续迭代、优化自身的软件栈及整个AI系统,久久为功、保持势头,不断提升性能优势。“仅通过两次MLPerf的提交,我们就能够在GPU最主流的模型上超过GPU,这是让我们非常自豪的一件事,而且Graphcore在未来还有更大的提升空间。”Graphcore大中华区总裁兼全球首席营收官卢涛补充道,“以前我们一直强调IPU是一个极具创新的平台,适合做一些新的应用,帮助创新者完成他们曾经达成不了的任务。这次的测试结果证明IPU确实能在已经成为主流的应用上落地,能落地则意味着可观的商业回报,这也是对行业而言比较重要的一个影响。”

Graphcore大中华区总裁兼全球首席营收官卢涛

大规模集群性能拥有强大优势

本次Graphcore提交的集群是IPU-POD128和IPU-POD256。除了IPU-POD16和IPU-POD64的时间优势之外,IPU-POD128和IPU-POD256此次能取得优异成绩主要在于其软件的可扩展性。“我们在设计软件的过程中考虑了很多因素,比如大量优化模型变形、数据变形、Kernel变形。同时,我们拥有非常细致的设计思路,让用户只需要写一个脚本、配置数据Replica的个数,就可以很自如地进行从1个IPU到256个IPU的横向扩展。”金琛指出,“除了在框架层面进行横向扩展,我们也在通信库上做了很大一部分优化。这方面的优化会为深度学习以及数据并行的深度学习带来显著影响。关于BERT-Large训练中5%和12%的提升很大程度上源于我们对通信库的改进。”

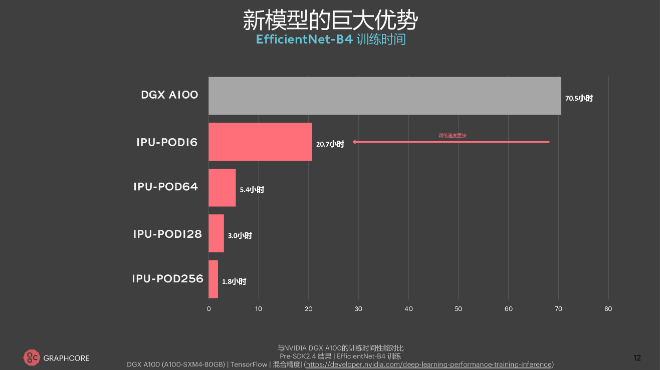

据介绍,Graphcore的系统扩展可以应用在更广泛的应用场景之中,包括用于自然语言处理的GPT类模型和用于计算机视觉的ViT(Transformer视觉模型)。“我们的系统软件设计及优化对新模型、新架构均非常适用。IPU系统可以非常平滑地从16个IPU一直扩展到256个IPU。”金琛表示。

以创新的计算机视觉模型EfficientNet-B4为例,DGX A100端到端的训练时间为70.5小时(官网数据),而IPU-POD16端到端的训练时间是20.7个小时,前者约为后者的3.5倍。随着系统的增大,时间逐渐缩短,EfficientNet-B4在IPU-POD256上的训练时间仅为1.8小时。“尽管这并非Graphcore本次向MLPerf提交的内容,但我们的大规模集群在实际应用中的确具备更强的性能优势。原来4天的训练时间现在只需2个小时,这会大大解放开发者的生产力,是我们大集群非常大的一个吸引力。”金琛解释。

“我们第一版IPU-POD的硬件是在2020年的12月份宣布量产的。一年内的硬件集群的增加、软件的优化,使得我们此次在IPU-POD256上的ResNet性能相较去年年底在IPU-POD16上的ResNet性能提高了50倍,这是一个非常大的飞跃。”卢涛认为,“我们的生态在过去半年中也取得了长足进步,拥有越来越多跨行业的商业用户、商业案例研究,例如天气预测、金融、保险、电信。”

回顾2021,卢涛指出,其自身遇到的最大的挑战可以用三个字来形容——“周期比预期要长”。不过,正如锤炼一柄传世宝剑,以精益求精之决心,历经千锤百炼后才能锻造出去杂存精的好剑。铸剑的过程是痛苦的,但宝剑内在美好的本质会被锤炼出来。这时,挑战亦为收获。“2021年我们确实扎根产业,着力落地应用场景,但整体来说,AI应用场景落地的整个链条很长,因此把整个方案变为一个产品是个挑战。”卢涛告诉记者。

兼具通用性与高性能,IPU发展经历了“热闹的2021”,将迎来“美好的2022”

在卢涛看来,2021年IPU的市场环境存在两个特点:第一是应用落地时间长于预期;第二是市场对IPU的期望强于预期。“今年年底时,我们发现市场的动能、惯性以及活跃程度,比年初时更为看好。这背后的原因在于多种因素组合所带来的积极推动作用,例如用户对市场、对自己应用的认知,对市场上各类处理器的认知,还有我们自身框架、应用、生态以及落地场景等方面的进展。随着更多资金的投入,2021年的市场环境将比2020年更为热闹。”卢涛告诉记者。

他指出,无论从计算机的体系结构抑或是用户角度来讲,IPU都极具通用性:“从指令级、架构上来看,IPU能够进行所有AI相关的业务,从CNN、RNN到LSTM,再到Transformer,所以IPU的通用性毫无疑问。假如不讲计算机的体系结构,用户判断产品的通用与否主要依据以下两点:第一、产品是否能开发出各种各样的应用。如果不同的应用都能开发,那么对用户而言它就通用。第二、对开发者来说,产品是否便于针对各种应用进行编程。如果能够编程,那么对开发者而言它就通用。所以从这两个维度来看,IPU是一个非常通用的产品。”

除此之外,高性能也是IPU吸引用户的关键因素。据介绍,在金融案例中,Graphcore的IPU产品比GPU快10倍;在保险算法模型方面,IPU比GPU快5倍;天气预测方面,欧洲案例证明IPU比CPU快50倍、比GPU快5倍;中国目前的场景显示IPU能够比CPU快60倍。“最近,斯坦福大学医学院在差分隐私的使用方面取得了重大突破。通过使用Graphcore IPU,斯坦福团队能够将具有差分隐私的人工智能训练速度提高10倍以上。IPU支持隐私计算非常吸引他们。”卢涛补充。

谈及IPU的技术发展趋势,卢涛指出以下三点:

第一,“Transformer-based everything”(基于Transformer的一切);

2017年,谷歌团队首先提出Transformer模型,该模型最初被应用于NLP领域,成效卓著。如今在计算机视觉领域、对话和语音领域,Transformer同样表现优异。随着GPT-2、GPT-3、AlphaStar等更多大模型重要成果的显现,Transformer预计会为更多领域带来革新。

第二,应用规模会越来越大、越来越复杂;

“之前大家比较关注单一的视觉任务和语音任务,后来AI又能应用于文字、语言、视频、图像,更加复杂,所谓称之为‘多模态’,这是一个重要趋势。”卢涛做出解释。

第三,AI融合科学计算。

卢涛表示,目前AI正在从互联网、自动驾驶等热门场景向与传统科学计算相结合的方向发展。例如DeepMind今年发布的AlphaFold(蛋白质方面的科学研究)、AI用于天气预测、宇宙学研究、分子动力学仿真等等。

基于此,卢涛表示,2022年Graphcore会相应地在三点进行发力:

第一,加大基于Transformer的应用上的投入。

ResNet于2016年10月发明,BERT于2018年10月出现。因此,自2016年5月成立以来,Graphcore在基于Transformer的应用方面呈持续追赶态势。“我们处于追赶当前市场霸主的位置,别人已经打磨很久了、做了大量的优化和工作。”卢涛表示,“即便这样,我们甚至只跟目前产业最领先的企业在transformer上只有三个月的差距。所以我们会在Transformer-based everything方面加大投入。”

第二,混合语言、语音、视频、图片,用AI进行更复杂的应用。

第三,加大对AI与高性能计算、科学计算融合的投入。

企业的技术提升离不开人才建设,因此Graphcore也会持续加强人才储备。2021年初,Graphcore中国团队只有20人左右,截至目前,团队人数增长四倍,达到80人。从全球来看,公司总人数也从年初的400多人增长至如今的600多人。据了解,随着AI在科学计算上的应用逐渐普适化,Graphcore也会在科学计算方面储备人才。“天气预测、分子动力学等领域会给国计民生带来深远影响,所以不光在深度学习,我们也会在高性能计算领域与大家一同开拓创新。”金琛告诉记者。“我们会脚踏实地,认真务实,相信Graphcore‘拟未’会有更美好的未来。”卢涛在最后总结。