阿里云通义千问系列AI开源模型升至Qwen2

5个尺寸、上下文长度最高支持128K tokens

2024-06-07

来源:C114通信网

通义千问(Qwen)今天宣布经过数月的努力,Qwen 系列模型从 Qwen1.5 到 Qwen2 的重大升级,并已在 Hugging Face 和 ModelScope 上同步开源。

附上 Qwen 2.0 主要内容如下:

5 个尺寸的预训练和指令微调模型,包括 Qwen2-0.5B、Qwen2-1.5B、Qwen2-7B、Qwen2-57B-A14B 以及 Qwen2-72B

在中文英语的基础上,训练数据中增加了 27 种语言相关的高质量数据;

多个评测基准上的领先表现;

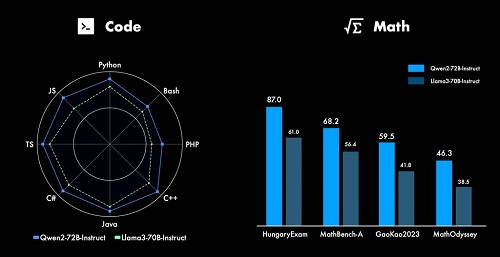

代码和数学能力显著提升;

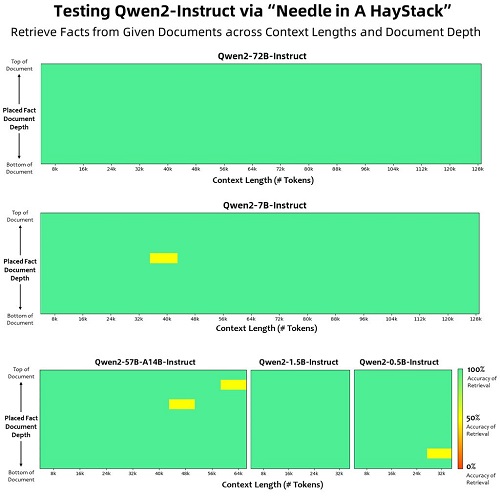

增大了上下文长度支持,最高达到 128K tokens(Qwen2-72B-Instruct)。

模型基础信息

Qwen2 系列包含 5 个尺寸的预训练和指令微调模型,其中包括 Qwen2-0.5B、Qwen2-1.5B、Qwen2-7B、Qwen2-57B-A14B 和 Qwen2-72B。

在 Qwen1.5 系列中,只有 32B 和 110B 的模型使用了 GQA。这一次,所有尺寸的模型都使用了 GQA,以便让大家体验到 GQA 带来的推理加速和显存占用降低的优势。

模型评测

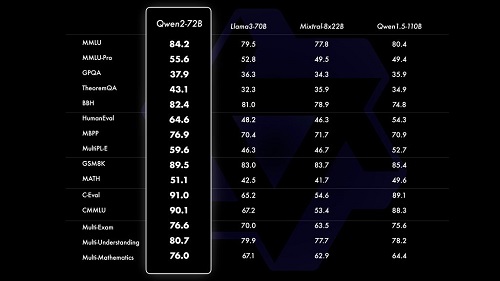

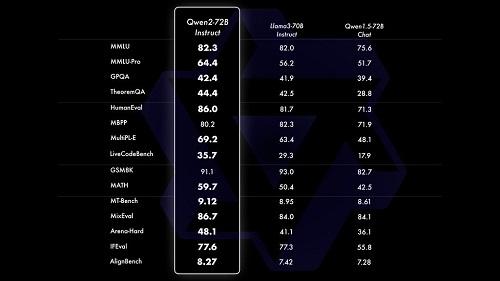

相比 Qwen1.5,Qwen2 在大规模模型实现了非常大幅度的效果提升。我们对 Qwen2-72B 进行了全方位的评测。

在针对预训练语言模型的评估中,对比当前最优的开源模型,Qwen2-72B 在包括自然语言理解、知识、代码、数学及多语言等多项能力上均显著超越当前领先的模型,如 Llama-3-70B 以及 Qwen1.5 最大的模型 Qwen1.5-110B。

本站内容除特别声明的原创文章之外,转载内容只为传递更多信息,并不代表本网站赞同其观点。转载的所有的文章、图片、音/视频文件等资料的版权归版权所有权人所有。本站采用的非本站原创文章及图片等内容无法一一联系确认版权者。如涉及作品内容、版权和其它问题,请及时通过电子邮件或电话通知我们,以便迅速采取适当措施,避免给双方造成不必要的经济损失。联系电话:010-82306118;邮箱:aet@chinaaet.com。