速看!openKylin本地部署并运行DeepSeek-R1全攻略!

2025-02-08

来源:openKylin

大家过年期间刷手机的时候,是不是感觉被DeepSeek“霸屏” 了?这款语言模型,一经发布直接在全球范围内爆火,成为顶流,在热搜上更是牢牢占据一席之地。无论是技术大神,还是紧跟潮流的技术小白,都被它强大的自然语言处理能力狠狠吸引,谁不想赶紧上手体验一把呢?

作为openKylin系统的用户,千万不要错过这波专属福利———一份超详细的在openKylin系统上本地部署并运行DeepSeek-R1开源模型的安装指南。手把手教学,包教包会,让你轻松开启这场超燃的技术探索之旅,赶紧跟着教程操作起来!

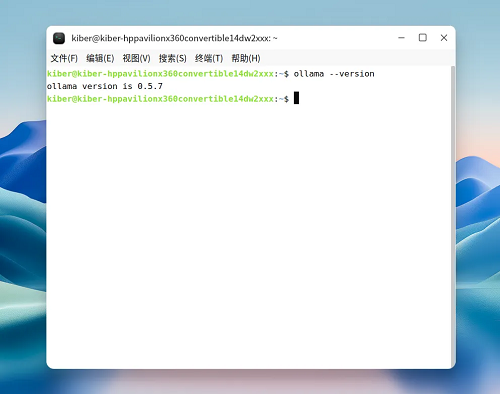

第一步:下载并安装ollama

·方式一:

按照ollama官网的下载指南,执行如下命令:

curl -fsSL https://ollama.com/install.sh | sh

·方式二:

前往github平台ollama项目自行下载后解压:

https://github.com/ollama/ollama/releases/tag/v0.5.7

执行如下命令进行解压缩:

sudo tar -C /usr -xzf ollama-linux-amd64.tgz

·方式三:

如以上两种方式因网络原因均无法成功下载,可通过关注openKylin公众号,回复ollama,获取百度网盘链接进行下载。

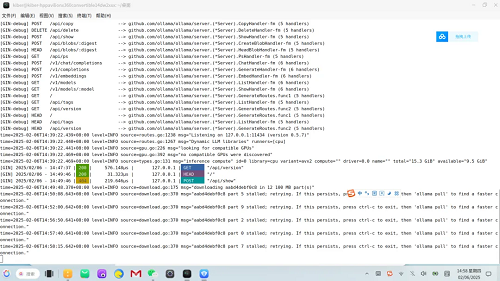

第二步:启动ollama服务

执行如下命令启动ollama服务:

ollama serve

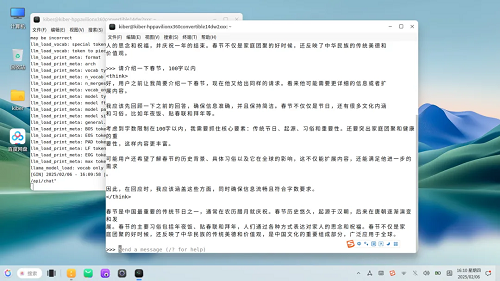

然后打开一个新的终端窗口,查看是否已启动成功,如下图所示:

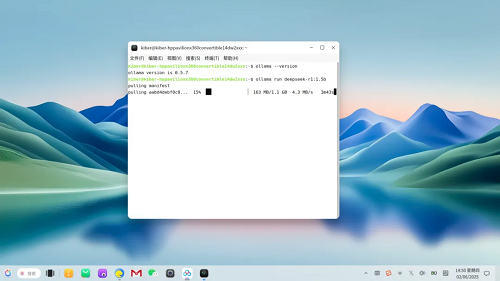

第三步:下载并安装运行DeepSeek-R1模型

执行如下命令下载并安装运行DeepSeek-R1 1.5b模型:

ollama run deepseek-r1:1.5b

注意:本次演示以1.5b模型为例,若您的电脑性能更高,可下载安装DeepSeek-R1更高规格的模型,效果更好哦!具体官方命令如下:

DeepSeek-R1-Distill-Qwen-1.5B

ollama run deepseek-r1:1.5b

DeepSeek-R1-Distill-Qwen-7B

ollama run deepseek-r1:7b

DeepSeek-R1-Distill-Llama-8B

ollama run deepseek-r1:8b

DeepSeek-R1-Distill-Qwen-14B

ollama run deepseek-r1:14b

DeepSeek-R1-Distill-Qwen-32B

ollama run deepseek-r1:32b

DeepSeek-R1-Distill-Llama-70B

ollama run deepseek-r1:70b

至此,已完成DeepSeek-R1模型的部署,接下来我们来问它一个问题测试一下:

可以看到,基于openKylin开源操作系统本地部署的DeepSeek-R1 1.5b模型,在较短时间内即可给出它的分析过程及最终答案。

通过以上的步骤,我们成功在openKylin上完成了DeepSeek-R1开源模型的本地部署与运行。希望大家在尝试的过程中,不断挖掘这两者结合的潜力,在各自的领域中实现更多创新。如果你在操作过程中有任何疑问或心得,欢迎在评论区留言分享,让我们共同推动开源技术与人工智能的发展!OpenAtom openKylin是由开放原子开源基金会孵化及运营的开源项目,由基础软硬件企业、非营利性组织、社团组织、高等院校、科研机构和个人开发者共同创立。

社区以“为世界提供与人工智能技术深度融合的开源操作系统”为愿景,旨在于开源、自愿、平等、协作的基础上,共同打造全球领先的智能桌面开源操作系统根社区,推动Linux开源技术及其软硬件生态繁荣发展。