王丹丹,夏斌

(上海海事大学, 上海 201306)

摘要:随着模式识别技术的发展与应用,睡眠自动分期方法正在逐渐取代手动分期研究。文章使用深度置信网络(Deep Belief Network, DBN)和长短时记忆递归神经网络(Long ShortTerm Memory Recurrent Neural Network, LSTMRNN)这两种方法对眼电(Electrooculogram, EOG)通道的数据进行睡眠自动分期。LSTMRNN方法(平均准确率83.4%)相对DBN(平均准确率75.6%)在基于眼电信号的睡眠分期问题上取得了更好的效果。

关键词:DBN;LSTM-RNN;睡眠自动分期;EOG

0引言

睡眠与人的健康息息相关。充足的睡眠可以消除疲劳,保证日常生活的正常进行,但是由于生活节奏的加快和压力的增大,现代人通常都存在不同程度的睡眠障碍。有调查显示,成年人存在睡眠障碍的比例高达30%。睡眠障碍会导致大脑功能紊乱,对身体造成多种危害,严重影响身心健康。因此对睡眠状况进行研究,了解睡眠质量,可以及早地诊断和治疗隐藏疾病。睡眠分期是将睡眠过程分为不同的状态。根据参考文献[1],睡眠过程分为三种状态:清醒状态(Awake)、非眼球快速运动睡眠状态(NonRapid Eye Movements, NREMS)和眼球快速运动睡眠状态(Rapid Eye Movements, REMS)。其中NREMS细分为四个状态:S1~S4,分别代表浅度睡眠、轻度睡眠、中度睡眠和深度睡眠。

睡眠分期的方法主要有两类:一类是基于R&K准则,需要经验丰富的专家对数据进行目测分类,这种方法不仅耗时费力,而且易受专家主观因素影响。另一类是睡眠的自动分期方法,其用模式识别算法自动对数据提取特征和进行分类。目前使用较多的有支持向量机(Support Vector Machine, SVM)、随机森林(Random Forest)、人工神经网络等。

由于深度学习可以自动提取特征,通过组合低层特征形成更加抽象的高层特征[2],因此本文利用两种深度学习网络分别对EOG进行分期研究,并对分期结果进行比较。

1方法概述

1.1深度置信网络

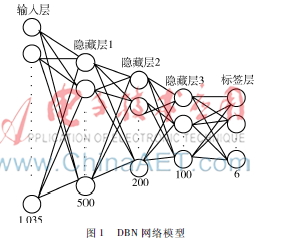

深度置信网络(Deep Belief Network,DBN)是Hinton在2006年提出的[3]。它由一系列受限玻尔兹曼机(Restricted Boltzmann Machines, RBM)组成。DBN网络的核心思想是将RBM堆叠在一起,训练出权值,将这个权值作为神经网络权值的初始值,再用经典的梯度法去训练网络。本文中用到的DBN结构如图1所示。DBN网络共有5层:输入层、3个隐层、标签层。隐层的单元个数分别为500、200、100。DBN的训练过程包括三步:(1) RBM的训练,需将数据划分为小批量的数据,HINTON G E在参考文献[4]中提出小批量数据的大小minibatche设置为10~100,本文中设置为60,训练迭代次数epoch设为10。 (2)将RBM训练得到的权重作为DBN网络的初始值进行训练。设置minibatche为1 000,epoch为30。(3)进行有监督微调,学习率设置为0.03。

1.2长短时记忆递归神经网络

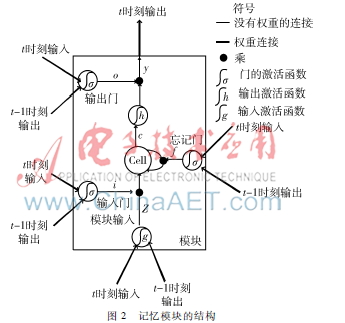

将每个受试的EOG数据看做一个序列,由于序列节点之间存在时序相关性,因此预测模型要具有记忆功能,能够包含序列的远距离信息。而递归神经网络(Recurrent Neural Network,RNN)恰好满足这一要求。RNN含有从单元的输出到单元的输入的连接(即含有递归连接),因此可以利用其内部的记忆来处理具有时序的输入序列。然而,传统的RNN存在梯度消失和梯度激增的问题,导致远距离的信息不能有效地被利用。为了解决这一问题,HOCHREITER S和SCHMIDHUBER J在1997年提出了一种新的RNN网络——长短时记忆递归神经网络(LSTMRNN),它使用记忆模块取代传统RNN的隐层单元,通过记忆细胞内部状态的自反馈和输入输出门对误差的截断,解决了梯度消失和激增的问题。LSTMRNN可以学习长度超过1 000的序列[5]。本文中使用的是具有忘记门的记忆模块,结构如图2所示。

LSTM层的权重的计算主要包括两个过程:前向传播和后向传播。

Xt表示t时刻的输入向量,W表示输入权重矩阵,R表示递归权重矩阵,b表示偏置单元。门的激活函数σ通常指的是sigmoid函数。记忆细胞的输入输出激活函数(g和h)通常是tanh函数。E表示损失函数,两个向量之间的点乘用“·”表示。

前向传播就是依次按照顺序计算模块内部各个组成部分的输入输出直至得到记忆模块的输出。

模块输入:

zt=g(WzXt+Rzyt-1+bz)(1)

输入门输出:

it=σ(WiXt+Riyt-1+bi)(2)

忘记门输出:

ft=σ(WfXt+Rfyt-1+bf)(3)

记忆细胞输出:

ct=zt·it+ct-1·ft(4)

输出门输出:

ot=σ(WoXt+Royt-1+bo)(5)

模块输出:

yt=h(ct)·ot(6)

后向过程就是从最后一个时间将积累的残差E传递回来。在此过程中采用的是BPTT[6](Back Propagation Through Time)算法。

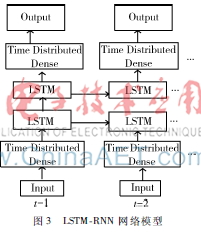

在本文中,将每30 s的数据作为一个时间步长进行输入,输出长度为6的向量,因此使用到LSTMRNN的网络结构如图3所示,其中TimeDistributedDense层是一个基于时间维度的全连接层。学习率和网络单元个数是图3LSTMRNN 网络模型网络的最重要的参数,而且各参数之间的调整可以看做是独立的[7],因此可以独立地对各个参数进行调优。最终参数的设置为第一层全连接层单元数为500,两层LSTM的单元个数为200、100,最后一层全连接层与第一层全连接层单元相同但是单元数设为6,batchsize为1,迭代次数epoch为128,学习率为0.003。

2实验数据

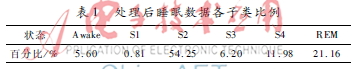

本文用到的数据是图宾根大学采集到的9名受试者晚上的睡眠数据,他们的平均年龄为23.5岁,其中包括3名女性。在实验前的6周,要求受试者们保持规律的作息时间并禁止喝咖啡。在本项研究中使用EOG通道,信号的采样率是500 Hz,专家将每30 s的数据对应于一个标签。由于本文对数据做6分类(AWAKE、S1、S2、S3、S4、REM)分析,因此只保留此6个状态的数据。首先对数据进行预处理操作:(1)去除两个不同状态转换时对应的数据,得到处理后各子类数据比例如表1所示。(2)将数据进行快速傅里叶变换,取0.5~35 Hz之间的频域数据。(3)进行归一化后得到用于分期的数据。表1处理后睡眠数据各子类比例状态Awake S1S2S3S4REM百分比/%5.600.8154.256.2011.9821.16

3实验结果

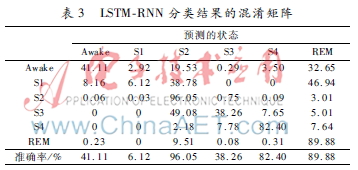

本文中使用留一验证的方法,图4展示了每个受试者DBN和LSTMRNN的分类结果。表2和表3展示的是两种方法对应的混淆矩阵。通过分析结果可以得到以下结论:(1)EOG数据可以用作睡眠分期研究。(2)DBN和LSTMRNN在睡眠分期研究中都取得了较好的结果,但是LSTMRNN无论是在每个受试者的准确率还是在每个状态的分类准确率上都要优于DBN。(3)在混淆矩阵中,S2、S4和REM的准确率比其他状态的准确率高,这与处于S2、S4、REM状态的数据在总数据中占得比例较高和各个状态具有相似特征有关。

4结论

本文通过基于EOG通道的睡眠分期研究可以得出,DBN和LSTMRNN作为睡眠自动分期方法,可以很好地自动提取特征并进行分类,在处理时序序列的分类时,LSTMRNN可以更好地利用长距离信息对睡眠数据进行分期,其分类效果优于DBN。

参考文献

[1] RECHTSCHAFFEN A,KALES A. A manual of standardized terminology,techniques and scoring system for sleep stages of human subjects[M]. Los Angeles: Brain Information Service/Brain Research Institute,1977.

[2] BENGIO Y,DELALLEAU O. On the expressive power of deep architectures[C].Proc of the 14th International Conference on Discovery Science. Berlin: SpringVerlag,2011:1836.

[3] HINTON G E,OSIJDERO S,TEH Y W. A fast learning algorithm for deep belief nets[J]. Neural Computation,2006,18(7) :15271554.

[4] HINTON G E. A practical guide to training restricted Boltzmann machines[J].Momentum,2010, 9(1):599619.

[5] HOCHREITER S, SCHMIDHUBER J. Long shortterm memory[J].Neural Computation, 1997,9(8):17351780.

[6] GRAVES A. Supervised sequence labelling with recurrent neural networks[M]. Berlin: Springer, 2012.

[7] GREFF K, SRIVASTAVA R K,KOUTNI'K J,et al. LSTM:a search space odyssey[J/OL]. arXiv preprint. (20150313)[20160301].http://arxiv.org/abs/1503.04069.