拥有2.6万亿晶体管的芯片

2021-10-27

来源:微波射频网

几乎就在Cerebras系统公司宣布采用最大的单个计算机芯片建造计算机的同时,这家硅谷创业公司也表达出了打造更强大处理器的意愿。2021年4月,该公司发布了新一代芯片Wafer Scale Engine 2(WSE-2),这款芯片将于今年第三季度上市。WSE-2的物理尺寸与其前一代芯片相同,但含有的各种组件数量都大幅增加。其目标是在机器学习使用的神经网络不断增大的情况下保持领先。

该公司的工程和业务拓展副总裁迪拉杰?马利克(Dhiraj Mallick)在一次声明中说:“在人工智能计算中,大芯片为王,它们处理信息的速度更快,可在更短的时间内得出答案,时间是人工智能进步的敌人。”

Cerebras一直在致力于将解决机器学习问题的逻辑方案发挥到极致。训练神经网络耗时太长,2016年安德鲁?费尔德曼(Andrew Feldman)创办该公司时,大型神经网络的训练需要耗时数周。其中最大的瓶颈是数据必须在处理器和外部动态随机存取存储器(DRAM)内存之间来回穿梭,这既耗时又消耗能量。最初Wafer Scale Engine的发明者认为,解决这一问题的方法是制造足够大的芯片,就在人工智能处理器核心旁容纳全部所需的数据。对于自然语言处理、图像识别和即将出现其他任务的巨大网络,我们需要一个非常大的芯片。要多大呢?越大越好,和一整块硅晶圆(切掉一点圆边)的尺寸差不多,即46225平方毫米。

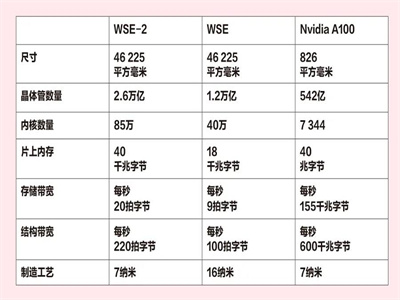

晶圆尺寸是WSE-2与WSE相同的少数几个数据之一,详情见下页表格。为了进行对比,表中也包含了英伟达的人工智能榜首芯片A100的数据。

2019年Cerebras发布WSE时,该芯片的制造商台湾积体电路制造股份有限公司(以下简称台积电,TSMC)使用的是16纳米制造工艺,当时这种技术已经有5年的历史。如今,台积电制造WSE-2使用的是7纳米工艺,据台积电的相关技术说明,这种工艺转变能使速度提升约40%,功率下降60%。

费尔德曼说:“改变节点时,总会出现物理设计的挑战。所有这一切都与几何相关。这非常难,但我们有台积电这个出色的合作伙伴。”

采用7纳米工艺本身就是一项重大进步,不过费尔德曼还表示,该公司还在增强了人工智能核心的微体系结构。虽然他没有谈到细节,但他表示,经过与客户一年多的合作后,Cerebras取得了一些经验,并将这些经验应用到新的核心。

Cerebras公司表示,其客户在打造新的人工智能芯片方面发挥了重要的作用。目前,该公司公开的客户包括美国国家实验室、制药公司葛兰素史克和匹兹堡超级计算中心。

用WSE-2做主机的计算机系统名为CS-2,该系统使用了几十万个核心来训练神经网络。软件允许用户使用PyTorch和TensorFlow等标准框架来编写自己的机器学习模型。然后,其编译器会物理连邻的WSE-2分成不同尺寸的分区,指派到神经网络的不同层。实现这一过程的方式是解决“布局与路由”的优化问题,确保每一层工作都能大致同步完成,信息在网络内流动不会出现失速。

与前一代系统一样,CS-2的体积也是标准机柜的1/3,功率约为20千瓦,依靠一个闭环液体冷却系统,还配备了一些大型冷却风扇。在开发WSE的主机系统时,热量一直是最大的问题。该芯片需要将约2万安培的电流从100万个铜接点输送到晶圆上的玻璃纤维电路板中。当热量使晶圆和电路板膨胀时,要保持所有组件排列对齐,这需要发明新材料。开发耗费了一年多的时间。虽然CS-2需要新的设计,但费尔德曼表示,这不需要大规模的新研发。

期待今年晚些时候能够在客户网络上看到WSE-2的性能数据。