入门:3D视觉技术和3D传感器初探

2023-02-09

来源:新机器视觉

【摘要】 1. 3D视觉技术2D视觉技术借助强大的计算机视觉和深度学习算法取得了超越人类认知的成就,而3D视觉则因为算法建模和环境依赖等问题,一直处于正在研究的前沿。3D视觉同样为传统研究领域,但最近5年内得到快速发展。与深度学习算法结合,在智能制造/机器人、自动驾驶、AR/VR、SLAM、无人机、三维重建、人脸识别等领域取得了优异的效果。3D视觉主要研究内容包括:l 3D感知:点云获…

1.3D视觉技术

2D视觉技术借助强大的计算机视觉和深度学习算法取得了超越人类认知的成就,而3D视觉则因为算法建模和环境依赖等问题,一直处于正在研究的前沿。

3D视觉同样为传统研究领域,但最近5年内得到快速发展。与深度学习算法结合,在智能制造/机器人、自动驾驶、AR/VR、SLAM、无人机、三维重建、人脸识别等领域取得了优异的效果。

3D视觉主要研究内容包括:

3D感知:点云获取及处理,应用于机器人/机械臂、自动驾驶、无人机等场景。

位姿估计(视觉SLAM):应用于机器人定位导航、VPS等场景。

3D重建:

大规模场景的3D重建、动态实景融合和3D理解(与3D感知趋于一致等),应用于数字城市/园区、数字文旅、混合现实等场景。

人脸、人体、手部3D重建和关键点检测识别,应用于游戏娱乐、动漫影视内容制作等领域。

近年来,学术界和工业界推出了一系列优秀的算法和产品,被广泛应用到各个领域。

学术界:

CVPR、ECCV、ICCV三大顶会每年和3D视觉相关主题的文章数量保持在十分之一左右,且呈增加趋势。3D视觉技术主要包括:3D点云识别与分割、3D物体检测、单目图像深度图的生成、语义SLAM、三维重建、光场计算等。

工业界:

3D视觉广泛应用到人脸识别、智能机器人、自动驾驶、ARVR等领域;比如,OPPO、华为和苹果等公司推出的3D+AI识别功能,通过扫描人脸三维结构完成手机解锁;自动驾驶领域通过分析3D人脸信息,判断司机驾驶时的情绪状态;SLAM方式通过重建周边环境,完成建图与感知;AR领域通过三维重建技术完成目标的重现,等等。

2.3D传感器" target="_blank">视觉传感器/相机

传感器/相机作为3D视觉的眼睛,其在3D技术演进及落地应用过程中所占的位置十分重要,甚至一定程度上决定了3D视觉技术的发展了应用。本文概要分析3D传感器/相机技术,并对当前业界硬件厂商和产品进行简单介绍。

3D传感器/相机,不仅能够获得平面图像,还可以获得拍摄对象的深度信息,即三维位置及尺寸等。3D传感器/相机通常有多个摄像头+深度传感器组成。可以实现三维信息采集,且三维数据可以转成点云。

根据基础原理的不同,目前市面上的3D传感器主要包括以下几种:

(1)双目相机

双目视觉是机器视觉的一种重要形式,基于视差原理并利用成像设备从不同的位置获取被测物体的两幅图像,通过计算图像对应点间的位置偏差,来获取物体三维几何信息的方法。目前有主动双目,被动双目之分,被动双目就是采用可见光,好处是不需要额外光源,但是晚上无法使用,主动双目就是主动发射红外激光做补光,光线暗的场景也能正常使用。

双目相机优缺点:

硬件要求和成本低,普通CMOS相机即可。

可适用室内外场景。

对环境光照非常敏感。光线变化导致图像偏差大,进而会导致匹配失败或精度低。

不适用单调缺乏纹理的场景。双目视觉根据视觉特征进行图像匹配,没有特征会导致匹配失败。

计算复杂度高。纯视觉的方法对算法要求高,计算量较大。

基线限制了测量范围。测量范围和基线(两个摄像头间距)成正比,导致无法小型化。

(2)结构光

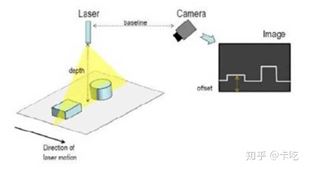

结构光(Structured light):通常采用特定波长的不可见的红外激光作为光源,发射出来的光经过一定的编码投影在物体上,通过一定算法来计算返回的编码图案的畸变来得到物体的位置和深度信息。

根据编码图案不同,机构光相机可分为:

一般有条纹结构光---enshape

编码结构光---Mantis Vision, Real sense(F200)

散斑结构光--apple(prime sense)

等

结构光相机优缺点包括:

方案成熟,相机基线可以做的比较小,方便小型化。

资源消耗较低,单帧IR图即可计算深度信息,功耗低。

主动光源,暗光线场景也可使用。

在一定范围内精度高,分辨率高,分辨率可达1280x1024,帧率可达到60FPS。

容易受环境光干扰,室外体验差。

随检测距离增加,精度会变差。

(3)ToF相机

不同于使用2D图像来推算3D资讯,ToF是透过红外光在空气中的飞行时间,计算出目标体的距离。ToF技术也是机器视觉工业的重要里程碑,因其只需要使用低成本的CMOS传感器和主动光源技术就能提供3D场景的距离景深资讯。

此外,不同于单点逐点扫描方式,ToF是每个图元都能测量对应目标体的亮度和反射回来的到达时间,从而计算出该点对应的距离景深。ToF提供了视角范围内场景的整个分辨率的距离景深资料。该技术结构简单,容易使用,不依赖环境光,且兼具高精度和高帧率。

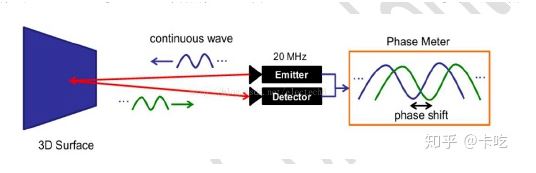

TOF法根据调制方法的不同,一般可以分为两种:脉冲调制(Pulsed Modulation)和连续波调制(Continuous Wave Modulation)。脉冲调制需要非常高精度时钟进行测量,且需要发出高频高强度激光,目前大多采用检测相位偏移办法来实现TOF功能。

下面图片描述了TOF相机(连续波)的基本原理,实际应用中,通常采用的是正弦波调制。由于接收端和发射端正弦波的相位偏移和物体距离摄像头的距离成正比,因此可以利用相位偏移来测量距离。

TOF的优缺点包括:

检测距离远。在激光能量够的情况下可达几十米。

受环境光干扰比较小。

对设备要求高,特别是时间测量模块。

资源消耗大。该方案在检测相位偏移时需要多次采样积分,运算量大。

边缘精度低。

限于资源消耗和滤波,帧率和分辨率都没办法做到较高。目前消费类最大也就VGA。

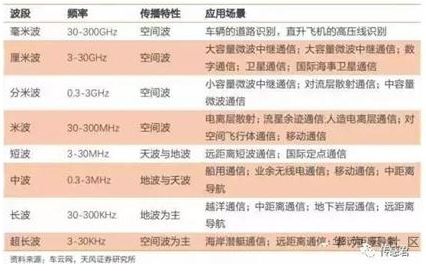

除了上述视觉传感器(相机)外,3D视觉相关的数据采集设备还包括:毫米波雷达、激光雷达等,广泛用于机器人、自动驾驶等应用场景。

毫米波是指波长在1mm到10mm之间的电磁波,换算成频率后,毫米波的频率位于30GHz到300GHz之间。毫米波的波长介于厘米波和光波之间,因此毫米波兼有微波制导和光电制导的优点。

激光雷达(Light Detection And Ranging,LiDAR),即光探测与测量,是一种集激光、全球定位系统(GPS)和惯性测量设备(IMU)于一身的系统,用于获得数据并生成精确的DEM(数字高程模型)。LiDAR可以高度准确地定位激光束打在物体上的光斑,测距精度可达厘米级,其优势包括“精准”、“快速”。下图为自动驾驶领域常用的Velodyne LiDAR。

近几年,无人驾驶技术兴起并快速发展。无人驾驶技术研发公司,包括谷歌、百度、Uber等主流无人驾驶汽车研发团队,都在使用激光雷达作为传感器之一,与图像识别等技术搭配使用,实现三维环境感知,为自动驾驶保驾护航。

LiDAR系统通过发射一束激光,测量光在物体表面反射而返回来的信号,信号传输所需的时间提供了一种直接测量LiDAR系统与物体之间的距离的手段。关于物体的额外的信息,比如它的速率或材料成分,也可以通过测量反射回来的信号中的某些特性而得以确定,这些特性包括诱导多普勒频移,从而创建出完整的3D模型。

更多信息可以来这里获取==>>电子技术应用-AET<<