摘 要: 针对未知非结构化室内环境中双目视觉机器人路标特征匹配的问题进行了研究,提出了基于改进自组织映射网络(Self-Organizing Map,SOM)的双目视觉特征点快速匹配方法。对双目视觉获取的环境图像提取SIFT特征向量作为改进SOM的输入,利用获胜者计算技术完成对输入SIFT特征点的快速匹配,SOM竞争学习过程中用街区距离与棋盘距离的线性组合作为相似性度量函数。实验结果表明,所提方法在路标特征匹配的时间和效果上优于传统SIFT和SURF特征匹配的方法,且能满足实时性要求。

关键词: 无监督竞争学习;特征匹配;双目视觉;自组织映射网络

0 引言

在未知室内环境中,移动机器人对自身与环境的精确定位是实现自主导航的前提和基础[1],而双目视觉可以获取更完整的环境信息、探测范围更广,匹配双目图像显著的特征点作为路标[2],构建机器人的环境地图是移动机器人实现自主导航的基础。

大多研究人员提出的算法主要是研究如何确定兴趣点和其相邻区域以及如何提取特征点的描述符向量。近些年不断有新的匹配算法被提出,参考文献[3]中提出对旋转、尺度缩放、亮度变化保持不变性的局部特征描述方法(Scale Invariant Feature Transform,SIFT)。该算法复杂度高,提取大量的局部特征点集,导致图像处理过程很慢,不能满足实时要求。参考文献[4]提出Harris-SIFT算法,用Harris角点代替SIFT算法的多尺度空间极值检测,生成SIFT特征描述子用在双目图像对的匹配上。但该算法失去了SIFT算法对于尺度缩放保持不变的特性。参考文献[5]改进了参考文献[4]的Harris-SIFT算法,保持了SIFT特性。采用Best Bin First(BBF)来减少匹配搜索的复杂度,提高了匹配速度。

本文提出一种SIFT特征向量提取与SOM竞争学习技术相结合的特征点快速匹配方法,大大减少了检测时间。实验表明,所提算法对特征点匹配的速度与效果优于传统SIFT和SURF匹配算法[6-7],满足移动机器人的实时性要求。

1 特征点提取

双目立体视觉系统由参数相同的两个摄像头组成,令两个摄像头的光轴互相平行且与透视投影平面垂直,要求同步曝光及图像质量一致。获取的左、右目图像分别记为IL、IR。分别对IL、IR提取SIFT特征点,每一个特征点对应一个描述符特征向量。描述符向量使用4×4的16个种子点来描述,通过高斯加权后归入8个方向直方图,获得一个4×4×8的128维SIFT特征描述子。由IL、IR提取的特征点组成的集合分别记为FL、FR,随后作为自组织映射网络(SOM)的输入进行特征点的快速匹配。

2 自组织映射网络(SOM)分析

基于Kohonen神经网络的SOM方法是一种无监督竞争学习的神经网络学习算法[8-9]。

设输入变量集合X={x1,x2,…,xk}∈Rn,权重系数W={wi1,wi2,…,win}∈Rn。随机选取W的初始值,将输入特征模式向量X输入到SOM输入层处理单元中,当网络得到一个新的输入模式向量时,竞争层的所有神经元对应的关联权向量均与其进行相似性比较,并将最相似的权向量判为竞争获胜神经元,由式(1)可以得到获胜单元。

在训练过程中,以获胜神经元为中心设定一个邻域半径,称为优胜邻域。优胜邻域内的节点也会彼此激发学习一个相同的输入向量X,优胜邻域Nj*(t)内的所有神经元节点由式(2)进行权值调整。

其中,(t)为学习率因子(0<(t)<1),优胜邻域开始定得很大,但随着训练次数的增加,优胜邻域会不断收缩,最终收缩到半径为零。

3 改进SOM的特征点匹配

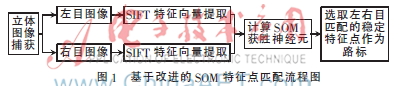

传统SIFT和SURF的特征匹配算法复杂度高,图像匹配效率低,不能满足实时性要求。本文运用改进的SOM网络完成双目图像特征点的快速匹配,加快特征点的匹配速度。基于改进SOM的特征点匹配流程图如图1所示。

修改后的算法把特征点匹配问题转换成一个图像的每个特征点与对应的另一图像特征点间立体映射的估计,所提算法选取街区距离LJ与棋盘距离LQ的线性组合代替欧氏距离Lo,可知计算LJ和LQ比Lo简单很多,而且LQ≤Lo≤LJ,所以本文用LQ+LJ替代Lo,作为相似性度量函数,减少了计算量,从而提高计算速度。

修改后的SOM特征点匹配步骤如下:

![`Y(YR0WZG0F~0WH]6QBGVM9.jpg `Y(YR0WZG0F~0WH]6QBGVM9.jpg](http://files.chinaaet.com/images/2016/01/04/6358750299179000003730744.jpg)

完成以上步骤后就完成了双目图像之间的特征点匹配。为了进一步提高匹配的准确率,使用极线几何约束、视差约束、有序性约束以及唯一性约束条件消除错误的匹配点。

4 实验与结果分析

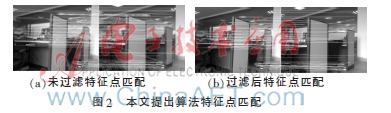

本文使用旅行家2号机器人作为实验平台,两个摄像头之间的基线长20 cm。对获取到的图像分别使用SIFT和SURF特征匹配方法以及所提算法进行特征点匹配。图2(a)为所提算法未使用约束条件进行特征点匹配的实验结果,图2(b)为约束条件过滤后的匹配结果。

从图2可以发现,未使用约束条件过滤前有明显的误配点,使用极线几何约束、视差约束等约束条件可以剔除大量的错误匹配点,提高匹配的准确度。图3为实验仿真对比结果,可以看出所提算法在匹配数量与时间上优于传统算法。获取大量图像对所提算法进行实验评估,统计运行耗时和特征点匹配数量如图4、图5所示。

本文用SIFT算法提取双目图像的特征点集作为SOM的输入,减少了检测时间。使用棋盘距离和街区距离的线性组合代替欧式距离作为相似度量函数,大大降低了计算量,减少了计算时间。使用获胜者计算技术保证了特征点的数量。

实验结果表明,所提算法在实验室环境下对双目图像特征点的匹配速度更快,且匹配的特征点数量稳定,可以满足机器人导航实时性的要求。

5 结论

SIFT算法具有尺度、旋转、视角和光照不变性,但由于复杂性高、效率低等达不到实时性的理想效果。本文使用SIFT特征点向量与改进的SOM相结合的无监督竞争学习算法,对双目图像特征点完成快速匹配。实验结果表明,所提算法在实验室环境下对双目图像特征点的匹配有较好的实验效果,可以快速、准确地匹配稳定的特征点。在未来的工作中,将在本文所提算法的基础上,进行双目视觉机器人实时定位与地图构建(Simultaneous Localization and Mapping,SLAM)[10]的研究。

参考文献

[1] 林睿.基于图像特征点的移动机器人立体视觉SLAM研究[D].哈尔滨:哈尔滨工业大学,2011.

[2] 王璐,蔡自兴.未知环境中基于视觉显著性的自然路标检测[J].模式识别与人工智能,2006,19(1):100-105.

[3] LOWE D G. Distinctive image features from scale-invariant keypoints[J]. International Journal of Computer Vision, 2004, 60(2):91-110.

[4] 赵钦君,赵东标,韦虎.Harris-SIFT算法及其在双目立体视觉中的应用[J].电子科技大学学报,2010,39(4):546-550.

[5] 王民,刘伟光.基于改进SIFT特征的双目图像匹配算法[J].计算机工程与应用,2013,49(2):203-206.

[6] 常青,张斌,邵金玲.基于SIFT和RANSAC的特征图像匹配方法[J].华东理工大学学报(自然科学版),2012,38(6):747-751.

[7] 陈小丹,杜宇人,高秀斌.一种基于SURF的图像特征点快速匹配算法[J].扬州大学学报(自然科学版),2012,15(4):64-67.

[8] KOHONEN T. Self-organizing maps[J]. Springer, 1995,11(3):340-349.

[9] 杨占华,杨燕.SOM神经网络算法的研究与进展[J].计算机工程,2006,32(16):201-203.

[10] 苏立.室内环境下移动机器人双目视SLAM研究[D].西安:西安理工大学,2010.