引言

深度学习技术的迅猛进步已使全球达成共识:人工智能技术(Artificial Intelligence, AI)将与核技术、生物技术和航空航天技术并驾齐驱,成为影响国家安全的关键因素[1]。2017年,美国率先提出“算法战”的构想,此后,全球主要大国纷纷将AI技术融入陆、海、空、天、网及电等多元化军事领域,以执行探测识别、威胁评估、情报分析及指挥决策等核心任务。2022年,美国退役上将约翰·艾伦预言,未来战争将迈入“极速战”的新纪元。所谓“极速战”,指的是一种高度依赖AI主导,人类指挥官极少介入的超快速战争模式。这预示着人工智能成为“重塑战争法则”的革命性技术。

目前,在国际军事舞台上,已有诸如美国“捕食者”和“死神”无人机、以色列的“铁穹”防御系统、英国的“塔洛斯”无人步战车等多个实例展示了人工智能技术的实战应用。此外,在国际联合军事演习中频繁使用人工智能辅助决策系统,能够整合来自不同来源的数据,为指挥官提供快速、准确的战场信息,从而加快决策过程。

对抗性攻击与人工智能技术的安全鲁棒应用息息相关。由于AI模型内部工作机理存在着不可解释性,一旦所使用的数据遭受攻击或篡改,将对模型的输出结果造成严重影响。这种通过对数据施加某种恶意干扰使得人工智能发生错误的技术就被称为对抗性攻击(Adversarial Attacks)技术[2]。目前,已经有大量研究表明对抗攻击所带来的数据安全问题可以极大程度地影响军事智能模型。2021年8月,兰德公司发布了《对抗性攻击如何影响美国军事人工智能系统》[3],通过实例深入剖析了对抗攻击对军事智能系统和作战行动的影响,并建议应切实加强对模型与数据集的安全防护。同年,韩国提出使用对抗性迷彩贴图来在物理场景下对数据施加扰动,实现军事目标的智能对抗[4]。2022年,英国研究了对抗攻击和数据的不确定性在混合战争(Hybrid Warfare)中的威胁。同年,Chen Yuwei评估了对抗攻击在搜寻、锁定、追踪、瞄准、交战和评估各个阶段可能造成的数据安全威胁,并使用仿真作战软件进行了验证[5]。

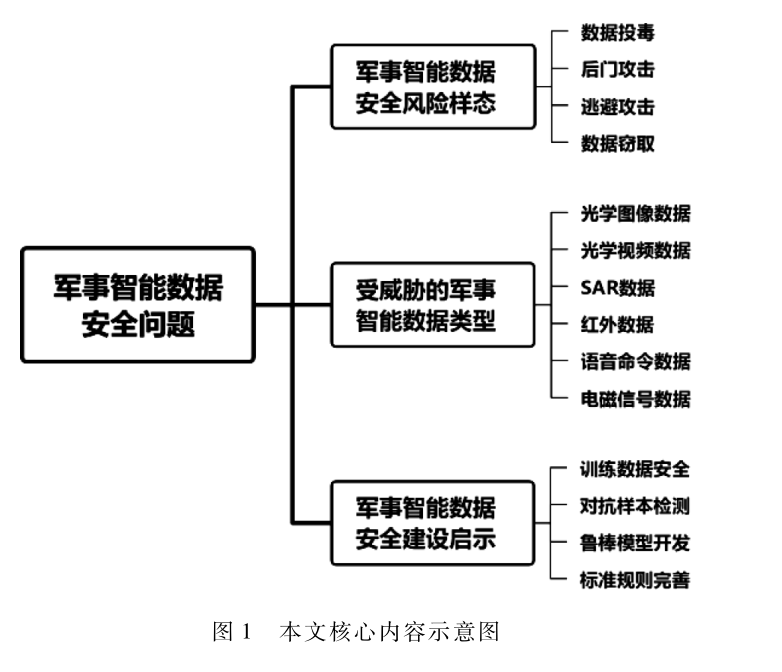

关注对抗攻击所带来数据安全问题对军事智能模型的可靠稳定部署有着重要意义。本文旨在分析军事智能模型所面临的数据安全风险及其具体形态,阐述对抗攻击技术的应用场景与部署方式,以期为智能化建设的稳健推进提供坚实的安全保障。本文的核心内容如图 1所示。首先对军事智能数据可能遭遇的四种风险形态进行了详尽阐述;然后列举了六种易受到对抗攻击威胁的军事领域常用数据类型,并详细描述了相关对抗攻击的具体部署方法;最后总结了为确保军事数据安全性所需采取的具体措施。

本文详细内容请下载:

https://www.chinaaet.com/resource/share/2000006225

作者信息:

陆正之1,黄希宸2,彭勃1

(1.国防科技大学试验训练基地,陕西西安710106;

2.国防科技大学电子科学学院,湖南长沙410073)