解析AI时代两大液冷技术差异

2025-02-13

来源:TechSuger

如今,随着机架功耗飙升至前所未有的水平,数据中心领域正在发生巨大变革。在计算密集型人工智能(AI)和高性能计算(HPC)应用的推动下,数据中心已迅速从只需采用风冷策略为10至20千瓦的机架散热,转变成为配备英伟达Grace Blackwell超级芯片的120千瓦机架散热——而这仅针对单个机柜的散热需求!

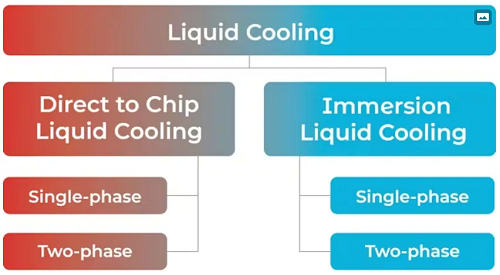

传统风冷技术根本无法有效应对如此高的散热需求,这为新型液冷技术的发展铺平了道路。当前主流液冷方案主要分为两大类别:"直触芯片式"与"浸没式"。与传统气体冷却方式不同,这些技术通过水或绝缘液体等液态介质来为设备散热。

随着行业向可持续AI未来迈进,为满足持续增长的计算需求而建立的AI工厂正在兴起,液冷技术必将成为数据中心应对散热管理、能耗控制及空间利用等核心挑战的关键赋能技术。事实上,面对新一代GPU高达1200瓦的功耗水平,液冷技术已从“锦上添花”演变为“绝对刚需”。随着全球对这项技术需求的激增,Mordor Intelligence等机构预测,到2029年,液冷技术市场的规模将达到148亿美元。

那浸没式与直触芯片式液冷的技术差异有哪些呢?两种方案均包含单相与双相两种技术路线。本文将从可持续性、能耗表现、易用性、风险控制、扩展能力及成本效益(见图1)等维度系统分析各方案的优劣势。

图1:市场细分显示直触芯片式与浸没式液冷方案下的技术变体。

沉浸式液冷技术:全浸没组件

浸没式液冷技术将服务器及其他电子组件完全浸没于绝缘液体中。设备运行时产生的热量被传导至周围冷却介质。受热后的冷却介质上升至液面,随后被输送至冷却系统进行热量消散,最后回流至设备所在的初始储液槽中。

沉浸式液冷有两种类型:

单相浸没

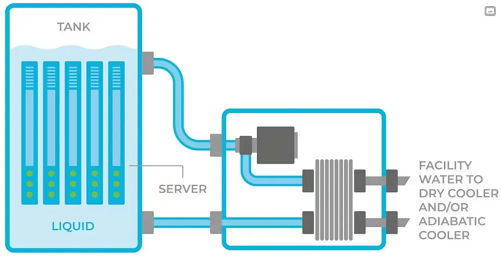

该技术方案将所有服务器及其他IT设备浸没于绝缘液体中。当CPU或GPU温度升高时,流体吸收其产生的热量。随后,这些受热流体被泵送至热交换单元进行冷却,冷却后的流体重新回流至设备所在的储液槽中(见图2)。

图2:单相浸没式液冷:设备完全浸没于绝缘液体中。

优点:

能完全吸收服务器产生的热量,这意味着服务器(GPU、CPU、内存模块等)散发的所有热量都能被收集并冷却;

采用绝缘液体,确保组件与服务器不会发生短路。

缺点:

热设计功耗(TDP)受限。当GPU的TDP超过700瓦时,单相浸没式方案难以提供有效散热;

需要对数据中心基础设施改造进行大量投资,因需配置大型重型储液槽来容纳设备。该技术更适用于新建数据中心,或具备充足空间且可进行大规模改造的现有设施,同时需确保建筑结构能够承载额外重量;

浸没槽内所有设备(包括服务器、连接器、印刷电路板等)必须与绝缘液体兼容,以避免被液体损坏。这通常需要选用专用设备或对服务器进行改造;

由于服务器部分组件(如光纤连接器)无法在浸没环境下正常工作,需对服务器进行机械重构;

所用含碳氢化合物的流体具有易燃易爆特性,若数据中心发生火灾可能导致灾难性后果;

服务器维护困难,任何维护操作均需使用起重机将单个服务器吊出储液槽,并需等待30分钟滴液时间后方可开始维修;

流体若受到污染(例如混入水),需排空并清洗储液槽,可能导致长达一整天的停机时间。

双相浸没

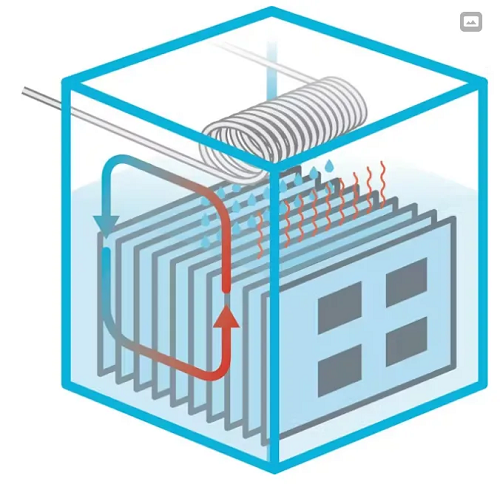

与单相浸没类似,该技术方案同样将服务器及IT设备完全浸没于绝缘液体中。然而,当电路板上的组件温度升高时,会使流体沸腾产生蒸汽,这些蒸汽从液体中上升至储液槽顶部。储液槽顶部设有冷却水管网络,当槽内蒸汽接触冷却管时发生冷凝,重新液化为液体滴回槽内;同时,冷却管中的水温升高,通过热水将热量带出设备,最终从数据中心排出(见图3)。

图3:两相浸没:服务器设备浸没于绝缘液体中。

优点:

能完全吸收服务器产生的热量,这意味着服务器(GPU、CPU、内存模块等)散发的所有热量都能被收集并冷却;

能够支持非常高的热设计功耗(TDP);

使用绝缘液体,确保组件与服务器不会发生短路。

缺点:

浸没槽内所有设备(包括服务器、连接器、印刷电路板等)必须与绝缘液体兼容,以避免被液体损坏。这通常需要选用专用设备或对服务器进行改造;

作为流体沸腾过程的一部分,强烈的气蚀现象会损坏信息技术部件、印刷电路板及焊接点;

需要对数据中心基础设施改造进行大量投资,因需配置大型重型储液槽来容纳设备,并加强建筑结构以承载额外重量;

由于液槽和浸没设备的重量,维护工作通常需要使用起重机,导致长时间停机。

每次开槽维护时,含全氟烷基物质(PFAS)的蒸汽会释放到环境中,每年造成约10%的液体损耗(数百升),并向大气中释放大量PFAS蒸汽。

直触芯片式液冷技术原理

与将整个服务器及其他IT设备浸没于液体中的浸没式液冷不同,直触芯片式液冷将冷却液输送至直接放置在高热流密度组件(如CPU和GPU)上方的冷板中。冷却液通过冷板吸收组件产生的热量,并始终封闭在冷板内部,不会直接接触芯片或服务器设备。

直触芯片式液冷被广泛认为比其他冷却方式更快、更高效,因为它能够精准针对主要发热区域进行散热。事实上,在近期Omdia分析师峰会上,他们的分析师指出:“当机柜功率超过50千瓦时,直触芯片式技术将占据主导地位。”

由于冷板主要安装在高热流密度组件上,因此服务器仍需配备风扇以排出低热流密度组件产生的多余热量。

直触芯片式液冷也有两种类型:

单相直触芯片式液冷

该液冷方法使用水作为冷板中的冷却介质。水始终保持液态,其散热能力取决于水流量——热量越高,所需的水流量越大。

优点:

凭借高流量的冷水,它能够为高热设计功耗(TDP)组件散热;

数据中心基础设施和服务器架构与风冷方案高度兼容,仅需微小改动即可集成冷板冷却系统。

缺点:

由于使用普通水而非绝缘液体,一旦发生泄漏,不仅可能损毁价值30万美元的服务器,还会引发腐蚀、发霉、残留物沉积、生物污染及其他环境问题;

随着水流速和压力提升,需要采用防泄漏性能更强的管路组件。

同时需配备更大功率的水泵来维持系统持续水循环。

两相直触芯片式液冷

与使用水的直触芯片式液冷不同,两相方案采用对IT设备100%安全的绝缘冷却液。GPU和CPU产生的热量在低温下使绝缘冷却液沸腾,利用高效的相变物理现象吸收热量,从而使芯片保持恒温。其原理类似于沸水使锅底维持在100°C,只是工作温度更低。

绝缘液体从液态变为气态,然后再回到液态的过程是在一个完全封闭的循环系统中完成的。即使热量增加三倍(比如GPU和CPU温度更高),冷板内的液体也不会超过沸点。因此,这种技术具有高度可扩展性,能够适应未来更高功率芯片的冷却需求。

这与单相直触芯片冷却方式形成鲜明对比,后者依赖于大量水的流动来冷却芯片。举例来说,一个使用两相直触芯片冷却技术的100千瓦机架,所需的绝缘液体不到4加仑,而浸没式冷却每机架则需要超过100加仑的冷却液。

优点:

无水直接芯片液冷:采用对IT设备100%安全的绝缘液体,即使发生泄漏(极不可能),也不会损坏服务器;

提升计算密度:支持单机架功率超过150千瓦;

面向未来:可支持单芯片功率高达2500瓦甚至更高;

与风冷相比,可节省高达80%的功耗;

由于液体保持恒温,服务器产生的热量可回收再利用,例如为邻近办公室、数据中心其他区域,甚至附近的学校和办公楼供暖;

几乎无需对数据中心基础设施进行改造,前期投资成本低,安装过程简单;

维护需求低:绝缘液体无需更换,且与浸没式液冷不同,在服务器和机架维护期间,这种冷却液不会释放到大气中。所用液体的臭氧消耗潜能(ODP)为0,全球变暖能值(GWP)极低;

即使下一代GPU的热量增加,仍可维持1U服务器规格。

缺点:

液冷仅用于CPU/GPU散热,其他组件(如内存、I/O等)仍需风冷。

条条大路通液冷

人工智能的未来发展很大程度上取决于数据中心扩容的能力,这将使数据中心内部的热量达到前所未有的水平。正如本文所述,目前有多种液冷技术可用于散热,但每种技术都有其优缺点。

数据中心和超大规模数据中心运营商需要根据成本、功耗、易用性、可扩展性和可持续性等因素,选择最适合自身的解决方案。只有这样,行业才能实现真正的人工智能可持续发展。