InfiniBand互联迎来新的发展空间

2021-07-10

来源:半导体行业观察

InfiniBand 互连是在上个世纪末关于服务器 I/O 未来的斗争中出现的,它不是成为通用I/O,而是成为用于高性能计算的低延迟、高带宽互连。在这个角色上,它无疑是成功的。

在过去的十五年中,InfiniBand已经扩展到用作与某些供应商的系统互连——IBM多年来将InfiniBand用作Power Systems和大型机上的外围I/O总线,但从未如此称呼过它。InfiniBand也被用作集群存储主干,现在是进行机器学习训练的AI集群的首选节点间网络。如果您正在构建一个数据库集群,您可能会选择 InfiniBand 互连,例如 Oracle 为其 Exadata 系统所做的那样。

20年后,事实证明,这是康奈利网络(Cornelis Networks)联合创始人之一、公司首席执行官菲尔·墨菲(Phil Murphy)的愿景的一个合理复制,在IBM和英特尔创建InfiniBand之后,他于1999年离开Unisys,并成立了SilverStorm Technologies,生产InfiniBand交换硬件和软件。PathScale是一家InfiniBand主机适配器制造商,被光纤通道交换机和收购QLogic适配器制造商在2006年2月以1.09亿美元的价格收购,随后QLogic随后在2006年10月以6000万美元收购SilverStorm,以补充近6年前以1500万美元收购Ancor Communications的InfiniBand交换机——有人说在InfiniBand交换机市场真正做好准备之前。

QLogic 将这些技术融合在一起,创建了 TrueScale InfiniBand 加载平台,该平台于 2012 年 1 月被英特尔以 1.25 亿美元的价格收购,并在服务器节点的 CPU 内核上运行大量网络软件堆栈——英特尔显然很喜欢这一点。仅仅三个月后,英特尔以1.4亿美元的价格从Cray手中收购了“Gemini”XT 和“Aries”XC 互连业务,并着手打造 Omni-Path 互连,将 InfiniBand 的一些概念与 Aries 结合,创建一个新的一种适用于上述所有工作负载的高性能互连。Omni-Path 是“Knights”Xeon Phi 计算加速器和英特尔整体 HPC 工作的关键组成部分。三年前,Knights CPU 被淘汰了 Omni-Path 现在正在 Cornelis 的指导下开设一门新课程——墨菲说这个课程更适合高性能计算和存储的当前和未来状态。

关于 InfiniBand 协议的一些历史是为了正确理解 Cornelis 将在其 Omni-Path InfiniBand 实施中做出的转变。

“InfiniBand的软件基础设施,基于verbs,实际上是基于InfiniBand的最初目标,即取代PCI-X和光纤通道,或许还有以太网,”Murphy告诉The Next Platform:“verbs根本不是为高性能计算而构建的。PathScale创建了Performance Scale Messaging,或PSM,它完全独立于InfiniBand verbs,是一个专注于 HPC 的并行传输层。在企业中,当与40或50个磁盘驱动器 40或50个队列对通话时,可以将其放在我的适配器的缓存中,并且效果很好。但是在HPC中,当有一个具有一百个内核和一千个节点的节点时,这将成为一个巨大的可扩展性问题,我们无法在适配器的缓存中进行管理。PSM 可以做得更好,但即使这是在20年前发明的,世界也在不断发展。我们看到 HPC、机器学习、数据分析的融合,现在也有加速器和 CPU 的混合。”

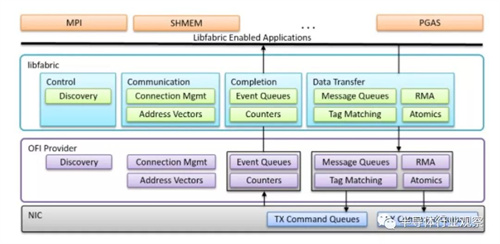

对 Cornelis 来说幸运的是,大约七年前,2004 年成立的 OpenIB 联盟的研究人员和技术人员创建了 OpenFabrics 接口工作组,以扩展远程直接内存访问 (RDMA) 和内核旁路技术,从而通过融合以太网提供 InfiniBand 和 RDMA (RoCE) 它们的低延迟以补充其对其他类型网络的高带宽。所述libfabric库是第一实施OFI标准的,并且其是上述网络接口卡和OFI提供商驱动器和MPI,SHMEM,PGAS和其他存储器共享协议之间跨在为HPC分布式计算系统通常运行一个层和人工智能。它看起来像这样:

“所有主要的 MPI 实现都支持 libfabric,分布式计算系统的各种分区全局地址空间(PGAS)内存覆盖也是如此,包括来自桑迪亚国家实验室的OpenSHMEM 以及 Mellanox InfiniBand、Cray Gemini 和 Aries plus Chapel的PGAS 实现,和英特尔Omni-Path互连。动词和 PSM 需要用某些东西替换,OFI 就是这样。OFI不仅是为现代应用程序而设计的,它是从头开始构建的,不仅可以识别节点中的 CPU,还可以识别加速器。这个 OFI 层是从网络到应用层的完美语义匹配。”

在这一点上,Cornelis 的团队自 2020 年 9 月揭开面纱以来已扩大一倍至 100 多人,他们为 OFI libfabric 创建了一个提供程序驱动程序,该驱动程序运行在 100 Gb/秒 Omni-Path 适配器之上,现在被替换为 Omni-Path Express。该适配器每秒可以驱动 1.6 亿条 MPI 消息,并且可以在运行在网络连接的两个不同服务器节点上的任意两个内核之间每秒驱动大约 1000 万条消息。Murphy 表示,对于任何 InfiniBand 实施,您最多可能会看到每个内核 300 万到 400 万条消息,因此每个内核的带宽增加了 2.5 到 3.3 倍。(显然,为了跟上处理器核心数量的增加和每个核心的更高性能,Cornelis未来必须获得更强大的 Omni-Path适配器。)至于延迟,对于最难改善延迟的小消息大小,Omni-Path Express 网络的核心到核心往返现在约为 800 纳秒,比使用旧 PSM 的 1 微秒往返低 20%司机。对于 HPC 和 AI 工作负载,这些都是带宽和延迟方面的重大改进。

Cornelis 也关注成本。在 InfiniBand 的大多数实现中,每个套接字有一个端口比让一个端口以两倍的速度运行要好,我们怀疑如果可以的话,您希望将每个端口从每个套接字上物理挂起。(这就是 TrueScale在 InfiniBand QDR 时代的全部意义。) Cornelis 说,使用单端口 100 Gb/秒 Omni-Path 适配器和 100 Gb/秒 Omni-Path 交换机的集群网络的成本将比Nvidia 100 Gb/秒 HDR InfiniBand Quantum 交换机和单端口 ConnectX-6 适配器设置的成本。对于网络的双轨实施,其中每个插槽都有自己的专用端口,Omni-Path 设置仍然便宜 25%。

Omni-Path Express 适配器和交换机现在处于技术预览阶段,大约有 20 位客户,可能在 11 月左右,正好赶上 SC21 超级计算会议,Cornelis 将普遍提供这种更新的 Omni-Path 堆栈。这对于全球 500 家左右以 Omni-Path 网络为集群核心的客户来说将是个好消息。新的 OFI 功能有可能通过固件更新,帮助客户在完全不接触硬件的情况下提升性能。

至于未来,似乎将跳过200gb/秒的全路径200系列,这是英特尔在2019年7月悄悄搁置的一代。这第二代的全能路径是合并更多的Aries互连技术,显然将打破向后兼容性-这是一个禁忌。Murphy说,Cornelis正在开发一种OFI适配卡,它有四个通道,每个端口以100Gb/秒的速度运行。我们推测配套的 Omni-Path Express 交换机可以有48到64个端口, 400 Gb/秒的最高速度运行,并且以 200 Gb/秒的速度运行该端口数的两倍。这些未来的 Omni-Path Express 开关和适配器预计将在2022年末上市,我们也猜测这些芯片将采用5纳米单片芯片设计,并使用中国台湾半导体制造公司作为他们的代工厂。就像英特尔对原始 Omni-Path 芯片所做的一样。